Toute prestation SEO complète nécessite un audit SEO et notamment un audit technique. Dans cet article, vous allez découvrir les étapes à suivre pour auditer la santé technique de votre site internet. Vous y apprendrez ainsi quels sont les outils utilisés par les consultants SEO, les points à vérifier pour vous assurer d’être au top d’un point de vue technique, mais également les pièges que l’on retrouve souvent sur les sites à auditer.

Qu’est-ce qu’un audit technique SEO ?

L’audit technique SEO est une prestation généralement proposée par une agence SEO, servant à analyser les aspects techniques d'un site et plus particulièrement ceux qui auront un impact sur son référencement. En effet, comme vous le savez sans doute déjà, le référencement Google se compose de trois principaux critères : contenu, popularité et technique. C’est ce dernier point qui est traité dans ce type de prestation.

Pourquoi faire un audit technique SEO de son site web ?

La prestation d’audit technique SEO permet de vous rendre compte de l’état actuel de votre site internet sur des points techniques qui peuvent avoir un impact considérable sur votre SEO.

Imaginez que vous interdisiez à Google de crawler tout ou une partie importante de votre site ? Ou encore que votre site soit bloqué par la majorité des navigateurs web ?

Ce serait évidemment un gros problème pour le référencement de ce dernier.

L’audit technique sert justement à éviter ce type d’erreur et à optimiser tous les aspects qui feront que Google adorera votre site.

Grâce à ce guide, vous aurez toutes les étapes clés pour réaliser un audit technique SEO complet. Vous pourrez ainsi appliquer les corrections nécessaires et avoir un site en meilleure santé. Il restera ensuite à vous concentrer sur vos contenus et votre popularité.

Quels sont les outils et logiciels nécessaires pour un audit technique ?

Tout bon référenceur dispose dans sa boite à outils de quelques scripts, logiciels et outils en ligne lui permettant de réaliser un audit technique SEO de manière efficace. Voyons ensemble les outils indispensables !

Un crawler

Google et les autres moteurs de recherche explorent le web en permanence à l’aide de robots circulant de liens en liens. C’est ce que l’on appelle crawler le web. Chez Google, ce robot se nomme « Googlebot », vous en avez surement déjà entendu parler.

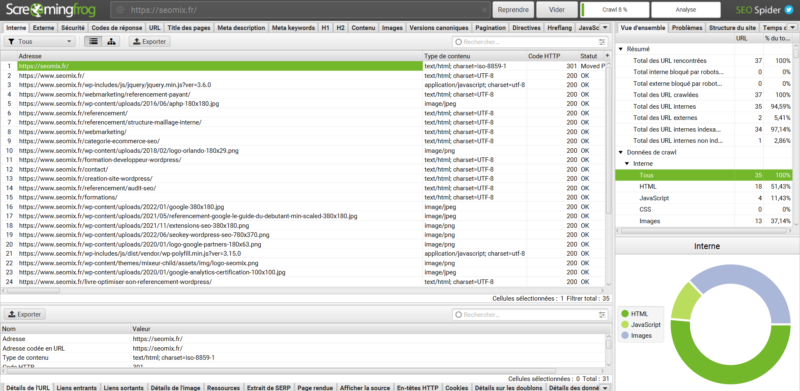

Un logiciel permettant de crawler votre site est donc obligatoire pour réaliser un bon audit technique SEO. En effet, utiliser un crawler SEO est la première étape pour détecter des erreurs que peut rencontrer le moteur de recherche. Pour ce faire, nous vous recommandons Screaming Frog, un logiciel indispensable si vous travaillez dans le référencement. Il est d’ailleurs gratuit pour les sites comportant moins de 500 URL.

Un navigateur web

Le navigateur web permet de réaliser diverses analyses techniques du site internet : vérifier la compatibilité mobile, utiliser des extensions de navigateur comme "SEO META in 1 click" pour faciliter vos analyses, utiliser des outils en ligne, comme GTmetrix pour évaluer le temps de chargement d'une page web, etc. Il permet aussi d’accéder à la Google Search Console dont nous parlerons plus bas.

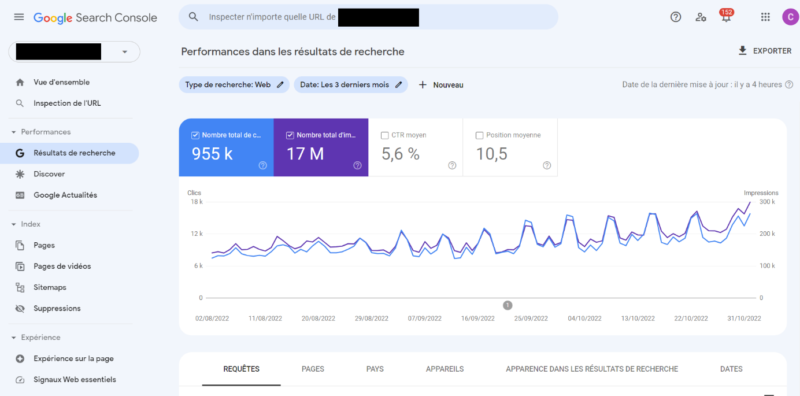

La Google Search Console

Classique me direz-vous, mais connaissez-vous vraiment cet outil gratuit qu’est la Search console ? Mis à disposition par Google lui-même, il regorge d’informations clés pour corriger votre site sur l’aspect technique. Vous y trouverez notamment les pages redirigées ou renvoyant une erreur 404, mais vous pourrez également tracker la vitesse de chargement de vos pages, voire leur comptabilité mobile, leurs données structurées et bien plus encore. Pour en savoir plus, n'hésitez pas à consulter notre guide complet sur la Google Search Console.

Outils en ligne

Beaucoup d’outils en ligne servent à gagner du temps sur plusieurs aspects de votre audit technique SEO, notamment pour tester la sécurité de votre site, sa vitesse ou encore les redirections liées à votre nom de domaine. Nous détaillons l’utilisation de ces outils dans les différentes étapes de l’audit technique SEO.

Vous avez ces outils ouverts sur votre ordinateur et vous vous sentez prêt pour vous lancer dans l’analyse technique de votre site internet ? C’est parti !

Réaliser un audit technique SEO : Les étapes

La réalisation d’un audit technique SEO passe par plusieurs étapes que nous développons ci-dessous :

Crawl du site

Commencez par lancer votre logiciel de crawl, à savoir Screaming Frog. Une fois que vous avez ajouté l’URL de votre site internet, allez dans « Configuration > SEO Spider » puis descendez pour ajouter le sitemap.xml de votre site internet.

Rendez-vous ensuite dans « Configuration > Accès à l’API > Google Search Console » puis connectez Screaming Frog à votre Google Search Console en suivant les étapes. Cette dernière étape permettra à Screaming Frog de récupérer plus d’informations qu’en analysant simplement le site en lui-même.

En parallèle, ouvrez un onglet sur la Google Search Console, vous y retrouverez divers onglets à analyser pour compléter l’analyse que vous réalisez avec le crawler.

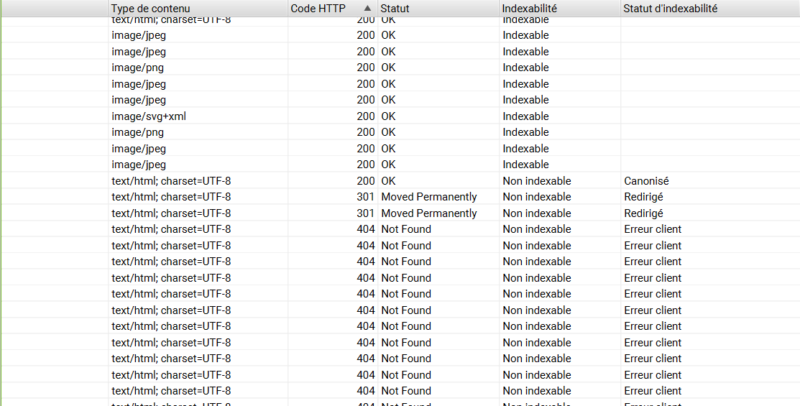

Les Codes de réponse

Repérez les liens internes en 301, 302, 404, 500, etc. Toutes ces erreurs peuvent être pénalisantes pour les moteurs de recherche. Il faut donc corriger ces liens internes et rediriger les URL en erreur. Pour vous aider à le faire, utilisez la section « liens entrants » de Screaming Frog. Le but ici sera d’obtenir le maximum d’URL qui répondent en 200.

Les Pages en noindex

Vous avez des URL avec un attribut « noindex » ? Dans ce cas, vérifiez la pertinence de leur présence sur votre site. En effet, pourquoi faire perdre du temps à Google avec des pages qu’il ne pourra pas indexer ? Supprimez donc les liens internes pointant vers ces pages pour que Google ne cherche plus à les visiter inutilement. Il s'agit souvent par exemple des pages "Mon panier" ou "Mon compte" sur les sites e-commerce.

Les URL canonisées

Listez les URL canoniques et canonisées présentes sur votre site internet : vous vous rendrez sans doute compte que certains liens internes mériteraient d’être remplacés ou supprimés. Cette pratique n’est pas forcément à proscrire, mais il faut la limiter à l’essentiel pour éviter de perdre en budget crawl avec des pages qui ne seront pas à indexer par le moteur de recherche.

Les pages orphelines

Les pages orphelines sont des pages qui n’ont pas de lien interne à partir du maillage interne du site, un potentiel problème pour la diffusion du PageRank sur votre site, listez donc ces URL pour contrôler la pertinence de votre maillage interne. Il vous faudra, en fonction de la situation, supprimer ces pages ou bien les rattacher au site via des liens internes.

Le niveau de profondeur

À l’aide de Screaming Frog, analyser la profondeur de vos pages est une étape fondamentale dans l’optimisation de votre maillage interne. En effet, plus une page nécessite de clics pour y accéder, plus Googlebot aura de mal à la trouver et la crawler. Sachez également que la quantité de PageRank envoyé vers des pages profondes sera plus faible. Veillez donc à optimiser votre maillage interne en tenant compte de ces bonnes pratiques.

Les images

Vous avez certainement des images sur votre site. Que celles-ci soient au format JPG, PNG ou encore WebP, elles peuvent ralentir votre site. D’une manière globale, listez les URL des images ayant un poids supérieur à 500 ko. Une fois ces URL listées, compressez-les pour les rendre moins gourmandes en ressources lors du chargement de la page.

Les PDF et autres médias

Listez les autres médias présents sur le site : vidéos, fichiers PDF… Une fois que vous disposez de cette liste, vérifiez que les fichiers respectent les bonnes pratiques du référencement : lisibilité pour les moteurs de recherche, balise title, liens, etc.

Les balises

Les balisages présents dans le code source sont importants en référencement naturel. Suite à votre crawl, relevez les pages n’ayant pas de titre H1, pas de balise title, etc. Autant de points à améliorer pour booster votre positionnement Google.

L'indexation de vos pages sur Google

L'indexation des pages de votre site dans le moteur de recherche est une étape cruciale pour générer du trafic. Grâce à la connexion de la Google Search Console à Screaming frog, vous pourrez détecter facilement des pages qui ne seraient pas indexées et qui devraient pourtant l'être.

Vous pourrez ainsi relever des problèmes d'indexation et les résoudre. Parmi les problèmes réccurents, on retrouve des problèmes de balises ne permettant pas l'indexation, de problèmes au niveau du robots.txt ou encore d'un maillage interne mal optimisé.

Un autre moyen de faire cette analyse sera de se rendre dans la Google search console, plus précisément dans le menu Indexation > Pages.

Analyse de la pagination

Limitez la pagination si possible et assurez-vous qu’elle soit bien réalisée. Elle ne doit comporter ni attribut canonique, ni indication noindex. Assurez-vous que Google puisse accéder en un minimum de clics à chaque page de votre site web.

Vérification des Sitemaps XML et HTML

Assurez-vous d’avoir un sitemap XML sur votre site et qu’il soit bien représentatif des URL à indexer par Google. Ce fichier permettra de faciliter l’indexation de votre site. N’oubliez pas de le soumettre dans la Google Search Console.

Concernant le sitemap HTML, celui-ci doit être présent en footer sur la page d’accueil, souvent nommé « plan du site ». Cette page regroupe les URL à indexer également.

Construction des URL

Il y a fort à parier que toutes vos URL ne soient pas bien construites d’un point de vue SEO, mais également d’un point de vue expérience utilisateur. Souvent, elles incluent des « stop words », des caractères spéciaux et sont très longues !

Pour vous donner un exemple concret, imaginons que vous rédigiez un article nommé : « Tout savoir sur les fiches Google My Business ».

Ne créez pas une URL de ce type : https://site.fr/tout-savoir-sur-les-fiches-google-my-business

Mais plutôt comme ceci : https://mondomaine.fr/fiches-google-my-business

Cette bonne pratique permettra d’améliorer l’expérience utilisateur et vous assurera une compatibilité avec tous les moteurs de recherche. N’appliquez pas cette recommandation pour modifier vos URL déjà existantes, au risque de créer des URL en 404. Gardez-la simplement en mémoire pour la publication de vos nouvelles pages.

Analysez la santé technique de votre site

Identifiez et corrigez les problèmes techniques qui freinent votre SEO.

Le Fichier robots.txt

Le fichier robots.txt (si vous en avez un) se trouve à l’adresse suivante : mondomaine.fr/robots.txt

Ce fichier permet de limiter l’accès de Google à certaines URL ou certains répertoires du site, idéal pour faire gagner du temps à Google.

Dans les faits, l’utilité du fichier robots.txt est à relativiser, car sur un site bien construit, les URL à ne pas explorer ne sont pas censées être accessibles via votre maillage interne. Si vous respectez cette pratique, le fichier robots.txt n'est pas utile dans la majorité des cas.

Pour l'exemple, voici ci-dessous le fichier robots.txt du site SeoKey, respectant évidemment ces bonnes pratiques 😉 :

Les ressources bloquantes

Vérifiez les types de ressources présents sur votre site web. Évitez notamment le flash et les iFrames. Ces formats peuvent poser des soucis vis-à-vis des navigateurs internet utilisés aujourd’hui.

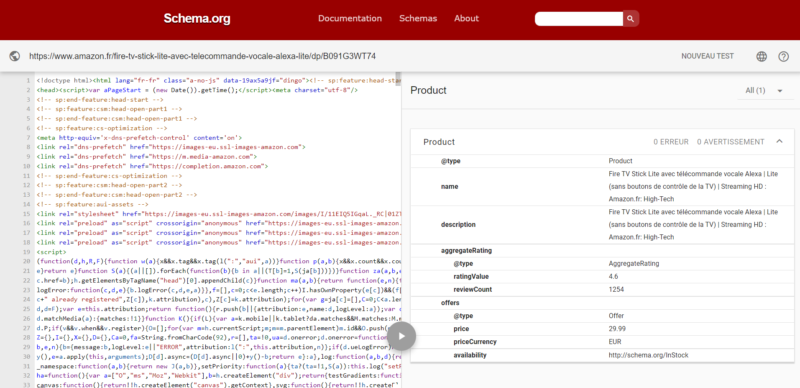

Les données structurées

Vérifiez via le site https://validator.schema.org/ la présence d’un fil d’ariane balisé en schema.org sur votre site. Celui-ci améliore la compréhension de la structure de votre site par Google.

Les données structurées ont étés créées pour faciliter la compréhension de certaines informations par les moteurs de recherche que sont Yahoo, Google, Bing et Yandex.

Par exemple, sur une page de recette de cuisine, il est recommandé d’ajouter le balisage schema.org « Recipe » qui donnera des informations supplémentaires telles que le temps de préparation, le temps de cuisson, etc.

Pour citer un autre exemple d’application, sur un site e-commerce, on retrouve souvent des avis rédigés par les acheteurs. Pour cette typologie d'information, le balisage « AggregateRating » permettra de donner une moyenne des avis publiés pour le moteur de recherche.

Parmi les balisages les plus populaires, on retrouve :

- Article

- LocalBusiness

- FAQ

- Organization

- Product

- Rating

HTTPS

Vérifiez que votre site dispose bien d’un certificat SSL et qu’il est donc en « https:// ». Cela permettra aux utilisateurs de naviguer de manière sécurisée et surtout de ne pas être bloqué par certains navigateurs web.

Vérifiez également les redirections des versions en « http:// » et avec ou sans « www ».

Analyse du temps de chargement

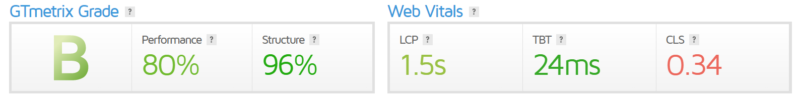

Assurez-vous que le temps de chargement de votre site est optimisé pour ne pas nuire à l’expérience utilisateur. C’est un point important à prendre en considération pour le SEO.

Vérifiez les performances de vos différentes pages importantes avec les outils GTmetrix et PageSpeed Insights. Vous pourrez ensuite effectuer les modifications nécessaires en fonction des ressources qui ralentissent votre site web.

De manière générale, voici quelques recommandations pour un site web rapide :

- Avoir un serveur performant ;

- Avoir un système de cache ;

- Optimiser et minifier les fichiers CSS et Js ;

- Réduire le poids des médias.

Compatibilité mobile

Google explore le web en version mobile, ce qui signifie que votre site internet doit impérativement être adapté aux mobiles, tablettes et autres appareils portables.

Sachez qu’un onglet nommé « Ergonomie mobile » présent dans la Google Search Console vous permettra d'analyser la compatibilité mobile de votre site internet et de relever des problèmes d’ergonomie comme un texte trop petit ou encore des éléments cliquables trop rapprochés.

Google mettait également à disposition un outil en ligne permettant de tester votre site sur ces points clés, mais il n'existe plus.

Pour aller plus loin et analyser ce point dans les détails, allez sur votre site via le navigateur Google Chrome puis faites clic droit > inspecter l’élément. Une fois la console du navigateur ouverte, vous trouverez en haut à gauche une fonction pour tester votre site sur différents modèles de tablettes et smartphones.

Une fois ce test effectué, demandez à votre entourage de tester avec leurs smartphones et tablettes votre site sur diverses pages pour vous assurer que votre site soit bien responsive.

Sécurité du site web

Un site internet bien référencé, c’est une chose. Mais dans un audit technique, il ne faut pas oublier le volet sécurité. Pour vous prémunir du piratage, suivez les bonnes pratiques énumérées ci-dessous :

- Réalisez une sauvegarde de votre site internet de manière périodique ;

- Installez une extension de sécurité comme Secupress pour WordPress ;

- Réalisez les mises à jour de votre CMS et des plugins ;

- Supprimez les extensions et thèmes inactifs et obsolètes sur votre CMS ;

- Veillez aux extensions que vous utilisez, leur fréquence de mise à jour, etc. ;

- Créez une URL de connexion à votre interface d’administration qui ne sera connue que par vous-même ;

- Renforcez vos identifiants pour que personne ne puisse les deviner.

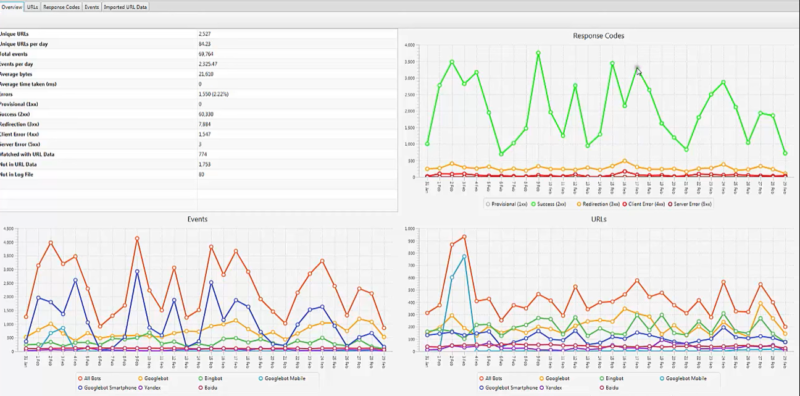

L’analyse de vos logs

Analyser vos logs vous permet d’extraire un grand nombre d’informations concernant le comportement de vos utilisateurs, mais aussi des robots sur votre site.

Pour votre analyse, nous vous recommandons « Screaming Frog Log Analyzer » qui permettra de rendre lisible votre fichier d’analyse de logs.

Vous pourrez notamment y traiter des informations telles que :

- La fréquence de crawl de votre site ;

- Les pages les plus crawlées ;

- Le budget crawl ;

- La vitesse de chargement.

Ces informations vous permettront d’aller plus loin dans l’analyse du comportement des robots des moteurs de recherche vis-à-vis de votre site.

Multilingue

Dans le cas où votre site internet est traduit dans plusieurs langues, il y a certains points auxquels vous devez faire attention.

Pour avoir un site web multilingue, 3 options s’offrent à vous :

- le sous domaine ;

- le répertoire ;

- un nom de domaine avec TLD géolocalisé, pratique la plus pertinente, mais également la plus contraignante dans la gestion quotidienne.

Pour aider les moteurs de recherche à comprendre que votre site existe en plusieurs langues, intégrez à celui-ci des attributs hreflang, qui indiqueront les différentes versions d’une URL en fonction des différentes langues.

Ne traduisez pas votre contenu tel quel avec un outil comme Google Traduction, veillez à faire une relecture complète des contenus et à adapter les mots-clés en fonction des différents pays ciblés.

Pensez par ailleurs à ne pas activer de redirection automatique en fonction de la localisation de l’adresse IP de connexion, sous peine de faire crawler très souvent votre site en version anglophone par Google. En effet, la majorité des robots qui crawlent le web sont basés sur des adresses IP américaines.

Optimisations de votre CMS

Il y a fort à parier que le CMS que vous utilisez soit perfectible. Dans tous les cas, son analyse doit être intégrée à l’audit technique. Si vous utilisez WordPress, vous devriez vous intéresser à nos articles traitant du référencement naturel WordPress, qui expliquent comment l’optimiser d’un point de vue SEO.

Gardez en mémoire que les CMS ne sont pas créés par des SEO et que chacun d’eux dispose de points perfectibles. C’est notamment le cas de WordPress, mais aussi de Magento, Shopify, Prestashop ou encore Wix pour ne citer qu’eux.

Les erreurs fréquentes rencontrées lors de nos audits techniques SEO :

Au cours de nos prestations d’audit technique SEO, certains problèmes reviennent fréquemment, en voici quelques-uns :

Des pages stratégiques orphelines

Une erreur qui revient souvent est le fait d’avoir des pages stratégiques d’un point de vue SEO, mais qui se retrouvent orphelines.

Les pages orphelines sont des pages qui ne reçoivent aucun lien interne, c’est-à-dire qu’elles ne sont pas accessibles par les moteurs de recherche et qu’elles ne reçoivent aucune popularité via les autres pages du site.

C’est pourquoi, ces pages auront du mal à se positionner dans les SERPS de Google.

Des redirections temporaires (302)

Autre problème récurrent, des URL redirigées en 302 au lieu de 301, concrètement, le page rank sera transmis de manière moindre à l’url finale, ce qui impactera négativement le ranking de celle-ci.

On retrouve parfois des 302 dans les liens internes du site, mais également des plans de redirection réalisés avec des 302, ce qui ne sera pas une pratique à adopter sauf dans des cas spécifiques.

Une pagination mal gérée

La pagination est un sujet complexe en SEO, et certains sites gèrent mal cet aspect pourtant primordial pour de nombreux sites.

Le principal problème rencontré par nos consultants : l’accessibilité des pages paginées par les moteurs de recherche. Voici quelques exemples :

- Pagination en AJAX (Google ne détectera pas les pages 2,3,4, etc) ;

- Pages paginées en noindex ;

- Pages paginées bloquées par le robots.txt ;

- Pages paginées avec une balise canonique vers la première page.

Le second problème, la profondeur causée par une mauvaise pagination. Dans certains cas (sites médias notamment), on se retrouve avec plusieurs centaines de pages paginées.

Si la pagination en place ne permet que de naviguer de 3 pages en 3 pages, se rendre à la page 150 peut nécessiter une quarantaine de clics !

Autant vous dire que pour les utilisateurs, ce n’est pas le top, mais pour Google… c’est un fléau !

Cela impactera directement la transmission du page rank, mais aussi l’accessibilité à Google de ces pages, celui-ci ayant un temps limité pour parcourir votre site.

Blocage par localisation et redirections automatiques

Selon les paramétrages de votre hébergeur, il peut arriver que vous bloquiez les utilisateurs géolocalisés dans certains Pays. Cela peut notamment poser problème si Google dispose de robots dans ces pays, ceux-ci ne pourront tout simplement pas crawlés votre site, et donc l’indexer.

On retrouve également un second problème avec les redirections automatiques en fonction de la localisation, si vous redirigez automatiquement un robot de Google crawlant depuis les USA vers la version anglaise de votre site, celui-ci ne pourra pas accéder aux autres langues. C’est pourquoi, vous devez éviter les redirections automatiques en fonction de la localisation.

Mauvaise gestion des balises canoniques

Pour terminer dans les erreurs fréquentes détectées dans le cadre de l’audit technique SEO, la mauvaise gestion des balises canoniques. En effet, selon la technologie, les extensions et les paramétrages que vous utilisez sur votre site, vous pouvez avoir des balises canoniques qui seraient intégrées à des pages et cela peut avoir tendance à desservir votre référencement.

C’est notamment le cas sur certains sites ou toutes les pages incluent une balise canonique vers la page d’accueil, ce qui reviendra à dire à Google : ne prends pas en compte ma/mes page(s), mais la page à référencer est la page d’accueil.

À vous de jouer !

Une fois votre audit technique terminé, vous aurez détecté un certain nombre de correctifs à appliquer. Vous pouvez vous en charger vous-même ou bien faire appel à nos développeurs et consultants si vous le souhaitez.

Une fois votre site optimal d’un point de vue technique, vous pourrez vous concentrer sur les contenus et la popularité de votre site pour lui faire gagner des positions sur des mots-clés pertinents pour votre activité, et ainsi générer du trafic qualifié. Chez SeoMix, nous proposons des prestations d’audit SEO ainsi que des accompagnements SEO pour vous créer une stratégie sur-mesure et vous épauler dans le développement de votre visibilité sur les moteurs de recherche.

N'hésitez pas à nous contacter dans le cadre d'une demande de devis SEO, Axel se fera un plaisir de vous accompagner dans votre projet !

Laisser un commentaire