Même si je doute fortement de l'impact réel de cette mise à jour sur la qualité globale des résultats, je connais plusieurs sites qui ont été touchés.

Comme je n'aime pas prendre pour argent comptant ce que nous disent les équipes de Google, j'ai réalisés quelques tests sur des sites touchés par cette mise à jour par rapport à des sites soit-disant "propres". Au passage, merci à ceux et celles qui m'ont envoyé l'URL de leurs sites, cela m'a vraiment aidé pour approfondir mon analyse.

Le résultat est sans appel : tous les sites pénalisés avaient un profil de lien absolument non "naturel". Comprenez par là un profil de liens clairement sur-optimisé, les autres sites "propres" n'ayant pas forcément des liens plus naturels ou de meilleure qualité...

Google Pingouin, c'est quoi

Avant d'expliquer cette mise à jour, il y a une chose qu'il faut savoir chez Google : ils peuvent agir de plusieurs façons sur les résultats. D'abord, ils ont la possibilité de modifier les résultats avec deux techniques :

- pénaliser un site : il reste dans l'index mais devient beaucoup moins visible.

- blacklister un site : c'est à dire le faire purement et simplement disparaître de son index.

Quand il s'agit du premier cas de figure, Google a également deux moyens pour agir :

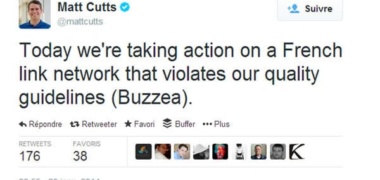

- Une action manuelle : dans ce cas précis, un employé de Google analyse manuellement un site pour décider ou non de le pénaliser ou de le blacklister.

- Une action automatique : ici, il s'agit d'une modification globale de l'algorithme de Google, qui va à un instant T modifier plus ou moins en profondeur les résultats. C'est le cas de Google Penguin mais également de Google Caféine (pour ne prendre qu'un exemple).

Dans le cas qui nous intéresse, il s'agit d 'une mise à jour algorithmique qui visaient tous les sites utilisant des techniques de "spam" pour mieux référenceur leur site Internet.

In the next few days, we’re launching an important algorithm change targeted at webspam. The change will decrease rankings for sites that we believe are violating Google’s existing quality guidelines.

Les traductions les plus courtes étant les meilleurs, voici ce que dit la citation et le reste de l'article : Penguin cherche à mettre à terre tous les sites dont les liens entrants ne sont pas naturels et dont le contenu est sur-optimisé, notamment les sites qui ajoutent le même mot clé partout (le "keyword stuffing").

Petit test sur cette mise à jour

Protocole de test

Pour essayer d'analyser ce qui peut faire basculer ou non un site sous la coupe de cette mise à jour, voici comment j'ai réalisé le testé. J'ai pris :

- 12 sites touchés par Penguin,

- 7 sites non impactés.

Ces sites ont des tailles et des anciennetés différentes. Certains datent de 2003, d'autre de 2011. Certains faisaient 3 000 visites par mois, tandis que d'autres avoisinent plutôt les 100 000. L'idée était de prendre des sites au hasard et de les analyser.

Au niveau du contenu, je n'ai malheureusement pas réussi à trouver des données communes ou similaires entre chaque groupe de site. J'avais utilisé Xenu Link Examiner, SeeUrank Falcon ou encore le site Alyse, mais je ne suis pas parvenu à faire ressortir des tendances suffisamment marquantes. Cette partie de l’algorithme de Penguin a donc été délibérément mise de côté dans mon article, ce qui ne veut pas dire qu'elle ne joue pas en faveur ou en défaveur de certains sites.

Au niveau des liens, c'est l'inverse : j'ai fait ressortir de réelles tendances communes entre chaque groupe de sites. Elles vont dans le sens de ce qui se dit déjà sur l'aspect naturel ou non des liens entrants. Vous allez le voir, les données parlent d'elles-même. Pour cette analyse, je ne me suis basé sur un seul outil d'analyse de backlinks : Ahrefs. Certes, ce n'est pas le plus exhaustif mais les données sont de suffisamment bonne qualité pour être traitées et être représentatives.

Voici les éléments que j'ai testé lors de ce test :

- le nombre de pages, de backlinks, de domaines et de subnets ainsi que de votes sociaux

- la répartition des backlinks par les liens nofollow, les liens texte et image, les ancres utilisées, les principaux sites référents et les extension de nom de domaine

- la typologie des pages, notamment la densité des mots clés, l'utilisation conjointe de H1, H2 et Title ou encore le nombre de liens internes et externes de la page d'accueil.

Nofollow et Google Pingouin

Je vais commencer par le plus évident : la présence ou non de liens en nofollow. En général, le référenceur les évite comme la peste pour n'avoir que des liens qui transmettent du jus. C'est une erreur car un lien en nofollow :

- peut apporter de la crédibilité (un lien wikipédia par exemple),

- peut attirer un grand nombre de visiteurs,

- permet de rendre son profil de liens plus "naturel".

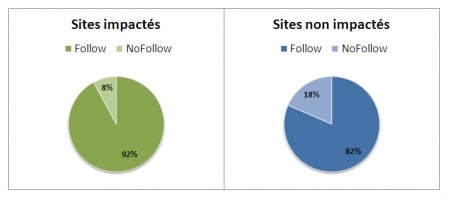

Sur les sites impactés, les liens nofollow représentent en moyenne 8% des backlinks, soit plus de 2 fois moins que les sites non impactés (avec en moyenne 18% de liens en nofollow).

En d'autre termes, l'attribut nofollow semble être un facteur pris en compte par Google Penguin, ce qui sera confirmé par les indices de corrélations dont nous parlerons plus loin.

Des référents trop présents

Je me suis aussi attardé sur les sites référents, et particulièrement ceux avec le plus de backlinks.

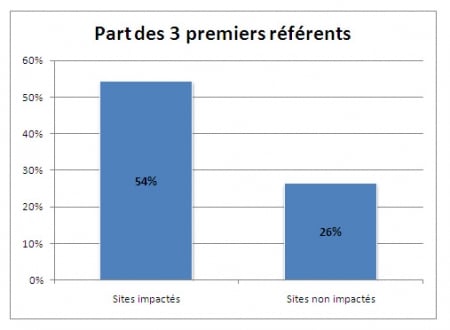

Pour chaque site touché par Penguin, j'ai regardé le nombre de backlinks total. J'ai pris ensuite les 3 plus grands sites référents pour calculer la proportion des liens provenant de ces sites. Là aussi, le constat est sans appel. Sur les sites impactés, les 3 premiers sites référents représentent en moyenne 54% des liens entrants, contre seulement 26% pour les sites non impactés.

Qu'est ce que cela veut dire ? Tout simplement que l'on a fait appel à quelques gros sites pour faire monter le sien. Cela inclut l'échange de liens, l'achat de liens ou certaines techniques de spamco comme les commentaires de blogs (pour apparaître dans les commentaires récents ou dans les meilleurs commentateurs par exemple).

Certes, il y aura toujours des sites qui feront plus de liens vers vous que d'autres, mais quand 3 d'entre eux représentent la moitié de votre linking, cela suppose un échange de liens ou alors un faible travail sur la création de liens sur d'autres domaines. En d'autres termes, vous semblez moins naturels.

Pas assez de crédibilité

Pour les données suivantes, j'ai comparé pour chaque groupe la proportion de backlinks par nom de domaine ainsi que la proportion de backlinks par Subnet (aussi appelé la "Classe C").

Pour ceux qui ne savent pas ce que c'est, un Subnet est un regroupement d'une série d'adresse IP "commune", en se basant sur la troisième partie de celle-ci. Voici un exemple :

//Subnets identiques :

168.254.112.123

168.254.112.180

168.254.112.012

//Subnets différents :

168.254.156.089

168.234.218.125En théorie, des sites ayant un Subnet identique appartiennent souvent au même propriétaire. En référencement, il est dit que des liens provenant d'une même classe C, c'est à dire d'un même Subnet, ont moins de poids. Attention, cela reste de la théorie donc prenez avec des pincettes ce que je viens tout juste de vous dire.

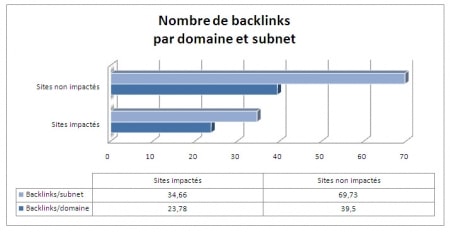

En ce qui concerne les données, j'avoue avoir eu beaucoup de mal à les comprendre car je pensais que j'allais trouver des chiffre inverses. En moyenne, les sites impactés par Google Penguin possèdent moins de liens depuis un même nom de domaine ou un même Subnet.

Je pensais que cela aurait été l'inverse car je croyais que les sites impactés auraient eu beaucoup plus de liens par domaine à cause de techniques de spams un peu "barbares" (Xrumer, LFE, ...), soit à cause d'échange de liens. C'est notamment ce que tendait à démontrer le point précédent, à savoir la part des 3 premiers sites référents dans l'ensemble des backlinks d'un site.

Je pense cependant avoir compris pourquoi. Un site "naturel" va générer "automatiquement" des liens. Un webmaster/client/fan/partenaire va donc en général créer plusieurs liens depuis un même site ou depuis un réseau de sites, ce que ne fera pas forcément le référenceur qui va chercher à obtenir un maximum de liens depuis un maximum de sites différents. C'est notamment le cas du spam de commentaire : en général, un référenceur qui commente un article pour avoir un lien va rarement revenir sur le même site pour poser un second, un troisième ou un quatrième lien.

Cela ne devient nuisible que lorsqu'un nombre trop restreint de sites font un lien vers le votre, comme avec nos données précédentes et les 3 sites référents qui dominent le reste des backlinks.

Des backlinks naturels

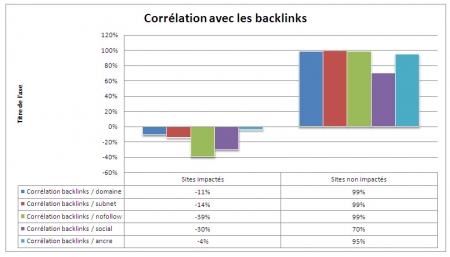

Le dernier graphique est le plus intéressant. Il reprend les données concernant :

- les domaines

- les subnets

- les liens nofollow

J'y ai ajouté :

- les votes sociaux pour la homepage. La question est de savoir est-ce que le site est populaire ou non.

- la diversification des ancres (nombre d'ancres différentes par rapport au total des liens entrants). En d'autres termes, est-ce que les liens utilisent des ancres différentes ou toujours la même ?

Comme je vous l'ai déjà dit, j'ai séparé en deux groupes les sites lors de mon analyse : les sites touchés par le Penguin et les sites qui ne le sont pas. J'ai ensuite calculé un indice de corrélation entre le nombre total de backlinks et les différents paramètres que je viens de citer. En d'autres termes, je cherche à savoir si en augmentant le nombre de backlinks j'obtiens ou non une augmentation proportionnelle des différents paramètres.

Pour ceux qui n'aime pas les statistiques, voici une courte explication des chiffres données par un indice de corrélation.

- 1 : c'est le maximum. Les données sont entièrement liées.

- 0,8 à 1 : les données ont une très forte corrélation.

- 0,6 à 0,8 : les données ont un fort lien.

- 0,4 à 0,6 : les données sont plus ou moins corrélées.

- 0,2 à 0,4 : les données sont peu liées entre elles.

- Moins de 0,2 : ne cherchez plus, elle n'ont pas de liens entre elles (enfin si, un peu, la nuit, par temps de brouillard, de dos, avec une alcoolémie trop forte et à 500 mètre de distance...).

Voici les résultats en pourcentage, 100 étant égal à un indice de corrélation de 1. A gauche, on retrouve les indices de corrélation des sites touchées et à droite ceux qui ne le sont pas :

La différence entre les deux est flagrante. Les sites non impacté ont systématiquement une réelle corrélation entre le nombre de backlinks d'une part, et des domaines, des subnets, des liens nofollow, des ancres utilisées et des votes sociaux d'autre part (dans une moindre mesure cependant pour le dernier).

Qu'est ce que cela veut dire pour votre référencement ? Et surtout, comment faire pour sortir d'une pénalité Penguin ? Tout simplement en suivant quelques conseils lorsque que vous créez des liens :

- Vous ne devez pas faire (trop) attention aux liens nofollow.

- Vous devez créer des liens sur un nombre toujours croissant de noms de domaines différents.

- Vous devez également renforcer les liens déjà créés, notamment en rajoutant des liens supplémentaires sur le même nom de domaine ou le même subnet. Évitez de faire du guest blogging "One Shot" par exemple.

- Vous devez IMPERATIVEMENT faire varier les ancres de tous vos liens !

Les données sont elles fiables ?

Je dirais oui et non pour répondre à cette question :

- Oui, car on note une corrélation des chiffres pour les sites propres et les sites touchés

- Non, car d'autres facteurs entrent en compte. Il ne faut donc pas se focaliser sur le pourcentage de nofollow ou encore sur la part des premiers référents.

Pour résumer ma pensée, voici ma vision des choses:

Le référencement naturel n'est pas compliqué, il est complexe.

De nombreux facteurs entrent en jeu et c'est le cumul de ceux-ci qui font monter ou descendre un site dans les résultats.

Etour ceux qui se posent la question au niveau de la pertinence de l'analyse avec un nombre si restreint de sites, il faut savoir que lorsque j'avais 3 ou 4 sites dans chaque groupe, j'obtenais déjà les mêmes données.

Google est à la traîne

Comme démontré ici, toute la partie de l'algorithme qui déclasse les sites ayant des liens vraiment non naturel s'explique facilement. Rappelez-vous, je n'ai pas trouvé de tendance réellement parlante de la sur-optimisation des contenus.

Cependant, j'avoue rester sur ma faim. Si je prends mes sites persos et certains clients, certains se sont fait dégagés et d'autres sont restés là. Et pourtant, dans les deux cas le référencement n'est absolument pas naturel et les liens souvent/parfois artificiels.

Il est "louable" de la part de Google de vouloir faire le ménage, mais je crois réellement qu'ils vivent dans un autre monde, rempli d'arc-en-ciel, de petits coeurs et de bisounours :

We want people doing white hat search engine optimization (or even no search engine optimization at all) to be free to focus on creating amazing, compelling web sites

En d'autre termes, Google veut que nous arrêtions de créer des liens pour nous mettre uniquement au référencement 100% White Hat. Ceci étant dit, aucun référencement ne l'est : un simple échange de lien, un commentaire de blog ou encore un lien dans un annuaire est par définition un lien non naturel, ce qui vous fait donc basculer du côté obscur. ^^

Ils souhaitent que nous nous concentrions sur la création de "magnifiques contenus bien conçus". Bonne chance Google, on est avec toi...

EDIT : for english readers, don't use Google Translate. It sucks. I don't claim to know how it works. I studied several website and i found some common points, that's all ;)

69 Commentaires

Pour avoir regardé sur mes sites (sans faire de tests précis), je suis tout à fait d'accord avec ton analyse. Les résultats sont rassurant dans un sens puisque l'on comprend mieux d'où vient le problème. Mais cela reste décourageant quand tu as des milliers de liens sur tes sites et qu'il est difficile de revenir en arrière...

Bel audit qui confirme beaucoup d'éléments que je pensais. Personnellement, le critère qui a le plus compté pour mes sites impactés est la sur-optimisation niveau ancres. En corrigeant cela, les remontées peuvent être rapides ;)

Bravo, Daniel un bel article.

Personnellement j'avais fait la même étude peut être un peu moins poussée car je m'étais focalisé sur certains facteurs.

Et j'en suis arrivé à la même conclusion.

Mais surtout j'ai une question: As tu changé tes reco ou tes actions auprès de tes sites et / ou clients?

Personnellement non, il n'y a strictement rien de neuf par rapport aux bonnes pratiques à savoir de la diversité, ps d'abus, rester dans sa thématique ou proche...

bref le seul truc où j'ai changé par rapport à il y a 3 ou 4 ans c'est sur le social qui n'était pas aussi développé. Maintenant je recommande fortement d'utiliser au plus ce levier pour légitimer le tout (sans parler de l'apport de traf non négligeable)

Voila donc moi quand je vois des personnes qui pleurent mais qui ont un profil de liens du genre 30k de Bls avec 25K de la même ancre ^^

Bravo Daniel pour cette étude et cette analyse qui me semble tout à fait pertinente !

Et surtout merci du partage.

Ton retour sur le Pinguin a le mérite de nous donner une base solide de réflexion et non des suppositions/ interprétations basées sur pas gros chose.

Je note que dans l'ensemble, cela confirme largement ce qui a été dit jusque là sauf concernant le fait de faire plus de liens issus d'un même domaine ou sous-réseau. Là j'avoue être aussi surpris que toi même si ton analyse sur ce point se tient également.

Je reste néanmoins septique sur ce point mais il a le mérite d'avoir été soulevé par quelque chose de tangible : si quelqu'un est motivé pour faire une autre étude juste sur ce point pour le confirmer ou l'infirmer, ça pourrait être très intéressant.

Sans avoir fait un test aussi poussé, j'ai remarqué un autre point, je ne sais pas s'il est réellement à prendre en compte ou pas. Le site (touché par pingouin) d'un collègue n'avait pas tous les symptômes présentés ici, à part le taux nofollow très faible.

Les liens étaient à 97 % dofollow, tous sur du texte, pas d'image et pas de redirection. Je t'avoue ne pas avoir regardé le partage social, mais j'ai tendance à penser "pas de lien redirigé = pas de partage"

Bref tout ça pour dire que le simple fait d'avoir trop de dofollow est déjà un signal important.

Excellent article ! Depuis un moment, on nous parle de pénalités liés aux CP, de sites déclassés etc... sans vraiment avancer de raisons valables et "scientifiques".

Bien que votre analyse mériterait d'être comparée avec d'autre, c'est une bonne base de réflexion sur la sur-optimisation de nos sites. Excellent :)

Super étude qui correspond dans les grandes lignes à ce que j'ai pu voir sur les sites impactés que j'ai sous la main.

Quand on voit le graph de corrélation, c'est sans appel. Bien sûr, certains diront que l'échantillon est toujours trop faible mais moi je pense que ces indications sont sur la bonne voie et sont très logiques (et c'est donc naturel).

Le nombre de liens par domaine est un critère intéressant à travailler je pense, je vois nettement que je l'ai fait sur certains sites et pas sur d'autres, et la pénalisation accompagne logiquement le 2ème lot... Hasard ?

Bonjour, les données et conclusions proposées par tes soins me semblent pertinentes. On tend vers un modèle de signaux et je pense qu'ils doit y'en avoir plusieurs en fonction d'autres paramètres. En tout cas merci pour l'effort.

Merci pour l'article, j'en retiens principalement qu'il est naturel pour un moneysite d'avoir plusieurs liens émanant d'une même source, alors que jusque là j'étais dans l'optique "plusieurs liens de la même source dévalorisent le linkjuice et donc deviennent inutiles voire spammy".

Même si il convient de pondérer tout cela, bien entendu, chaque cas étant...unique ^^

Très intéréssant cet audit !!

Tes données confirme ce que beaucoup d'entre nous pensait : un référencement naturel est un éternel compromis des différents critères seo : ancre, nbre de backlink, nombre de domaine référent, autorité des domaines, lien dofollow et nofollow, partage dans les réseau sociaux...

Je suis tout à fait d'accord avec toi quand tu dit que le référencement n'est pas compliqué mais complexe.

On ne se repose plus sur un ou deux critères car le référencement est devenu multifacette, multicanal et donc par définition plus complexe à réaliser.

C'est tant mieux pour les référenceurs pro qui vont pouvoir mettre encorep lus en avant leur expertise.

Après ce que je ne comprend pas avec Google c'est leur vision du seo, il vive dans leur monde avec un temps de retard considérable sur l'évolution des intéractions entre site d'un même marché. Leur mise à jour ne sont que des rustines pour essayer de réparer leurs erreurs ou laxisme passés.

Du coup il ne peuvent que naviguer à l'aveugle en shootant les gros sites qui comme un chateau de carte font tomber les petits.

Ce qui est vraiement affligeant ce sont les résultats des SERPS souvent très peu pertinent, en privilégiant les gros sites d'un secteur d'activité, ne laissant que peu de place au petit qui peuvent apporter beaucoup plus parfois. Il encourage à mon sens une sorte de monopole du web dans certain secteur concurrentiel : quel manque d'objectivité ! mais venant de google ça ne me surprend qu'à moitié.

Chapeau bas, Daniel, ça c'est de l'analyse !!

Un article appuyé par des graphiques etc. Bravo Daniel :)

J'ai quand même l'impression pour ma part qu'il y a eu beaucoup d'interventions manuelles sur le pinguin.

Possible qu'il y ai eu une remonté automatique due à l'algorithme, mais aussi, dans de nombreux cas, une pénalité infligée manuellement. Et je pense qu'il y a un facteur à prendre en compte aussi : Le design et la qualité de la mise en page.

Bonjour et Merci Daniel !

Pour info, je suis tout à fait d'accord avec tes conclusions.

On approche d'une "solution" ;-)

Merci.

Bravo pour cet article. C'est un très bon début pour comprendre exactement la stratégie à adopter.

D'un coté, ça parait logique, trop de dofollow est aussi un signe de liens non naturels non?

Juste hier je me disais qu'il aurait été intéressant de faire ce type d'analyse, aujourd'hui tu en publie une, c'est parfait ! ^^

C'est bien expliqué et (même si je suis mauvais en stats) le résultat parait cohérent, donc merci pour ce beau test, ça fait plaisir à voir des articles comme ça.

Intéressante ton étude, merci ! Tu confirmes mes doutes et même si on ne peut pas tirer une conclusion définitive de tes tests, de grandes lignes se dessinent et confirment certains de mes doutes au sujet de netlinking. Bon allez, on part donc à la recherche du nofollow et on sort le balai pour nettoyer les mauvais liens ;)

Merci pour cette étude fouillée et synthétique de laquelle on ressort avec des acquis pour son travail de ref.

J'ai 1 questions :

"Vous devez également renforcer les liens déjà créés, notamment en rajoutant des liens supplémentaires sur le même nom de domaine ou le même subnet. Évitez de faire du guest blogging "One Shot" par exemple."

Ce conseil n'est-il pas en contradiction éventuelle avec l'impératif de varier les sources de backlinks. Pouvez-vous préciser ce point ?

Merci pour ce résumé. Mon expérience (non chiffrée) va aussi dans le sens de vos conclusions. Je rajouterai que je n'ai pas vu l'effet de l’optimisation on page, j'ai même l'impression qu'un site sur optimisé en keyword stuffing à toujours l'avantage sur un qui n'en est pas.

Il aurait été bon aussi regarder les liens sortant et leur autorité. Car j'ai l'impression que cela joue aussi (ex: pas de lien sortant = suspicion).

++

Pour du linkbaiting tu as fais fort ^^ Cet article est vraiment très très intéressant. Sur tout le web on peut voir les techniques à mettre en place maintenant que Pinguin est arrivé mais on n'a pas vu d'étude aussi poussé. Félicitation.

Comme la plupart, je suis surpris d'apprendre qu'il faut faire plusieurs liens depuis un même domaine. Je vais devoir te spammer plus souvent alors xD

Si tu as d'autres études du même genre n'hésite pas à faire partager :)

Article très intéressant Daniel.

Je repose mon commentaire car ton serveur a eu un petit pic de charge juste quand je l'ai publié.

Je me demandais si tu avais remarqué une corrélation entre la répartition des ancres et les différents types de tld.

Par exemple, les sites en langue française ne sont pas sanctionnés quand ils ont à minima 10% de .fr ?

Voici un article de référence sur Pinguin, comme on aurait aimé l'avoir sur Google Panda. La méthodo et les conclusions me semblent très bien pensés. Félicitations !

Pour les classes C, personnellement je ne vois pas comment ça pourrait jouer en faveur ou défaveur. Ce serait absurde. La plupart des sites de la planète sont hébergés sur des serveurs mutualisés. Ils y sont stockés par lot de 10, 100, 1000 ... tous avec la même IP (hors failover).

En tout cas merci pour le partage, ça confirme pas mal les analyses déjà menées.

Pour ce qui est de la variation des ancres, bien sur c'est très important.

Je me permets de te demander une analyse de plus (un nouvel article ?) : voir si les sites non pénalisés ont des ancres typées notoriété plus que ceux pénalisés.

bonjour et merci pour cet article fortement détaillé car là je peux enfin mettre une explication sur ce fameux google pingouin dont me parle trop souvent mon mari et que je fais mine de comprendre. Maintenant je pourrais lui répondre en lui faisant croire que je l'écoutait vraiment lorsqu'il m'en parlait;)))

Très bonne idée d'avoir fait cette étude. Je rajouterai d'après ma propre expérience, de varier les sources de liens. Un site qui ne fait que du spamco ou que de l'annuaire se fera pincer plus facilement que celui qui diversifie ses sources.

Sinon, étonné aussi de la conclusion sur les référents. Et c'est vrai qu'on ne revient quasiment jamais commenter où on est déjà venu...

Je pense que c'est l'un des tests les plus poussé que j'ai pu lire depuis l'arrivé de la bête à plumes.

Merci pour ce résumé claire, qui confirme mes pensées sur le besoin d'avoir un netlinking le plus naturel possible.

as-tu tenté de faire un rapprochement entre le nombre de visites que reçoit un site et le nombre de liens qu'il reçoit dans le même temps ?

Merci pour cet article !

J'en ai bien besoin...

Merci pour cet article complet et intéressant.

Bien que ton étude porte sur un nombre assez faible de sites, les statistiques que tu en tires sont suffisamment marquées selon moi pour être fiables et permettre de dégager les principaux critères.

Pas plus tard qu'hier, j'ai un client qui est venu me demander les raisons de la perte de trafic qu'il a observé depuis le 24 avril sur un de ses sites satellites ... et très clairement, les "problèmes" les plus flagrants de son site sont:

- suroptimisation (title, keywords, content, tout y passe)

- liens sortants vers un unique domaine

- liens entrants exclusivement fait depuis des annuaires

- etc.

Je suis même étonné qu'il n'ait pas été pénalisé plus tôt !

Étude très intéressante et très poussée de l'effet du manchot.

J'avoue moi aussi être très surpris des résultats liés au subnet.

J'ai supprimé tous les liens venants de mon serveur sur les différents sites juste après, bon cela dit sur le seule site impacté ça n'a rien changé.

Mais je pense que le secret réside dans une pincée de chaque ingrédient pour ne pas faire bourrin et essayer de ne pas avoir uniquement des ancres optimisées, mais c'est dur quand on a l'habitude :-D

En tout cas merci du partage et du gros travail d'analyse réalisé pour ressortir ces données.

Analyse poussée, graphiques à l'appui et plusieurs sites analysés : c'est du solide ton article. Cela confirme mes analyses et mes résultats sur mes sites. Je sais ce qu'il me reste à faire...

Pas mal du tout, cet indice de corrélation.

Je ne comprends pas trop comment il peut être négatif, par contre...?

Si tu supposes que :

0% = non corrélés

et 100% = corrélés

Mais bref, on voit bien l'idée en tout cas.

Excellente étude, même si bien évidemment de nombreux autres paramètres sont à prendre en compte. Ce serait vraiment trop facile si Google se focalisait uniquement sur 6 critères distincts pour établir ses classements. Chaque cas étant unique, il ne faut pas non plus prendre les résultats de cette étude pour des généralités ! Google nous a appris que ce qui fonctionnait hier pouvait très bien devenir inefficace demain...

En effet stimulante cette analyse.

J'ajouterais les remarques suivantes :

- Quid de la présence de lien d'affiliation ou de trop de publicité sur les sites impactés ?

- Tout le monde constate une baisse marquée de trafic depuis Pinguin. Mais qui a déjà réussi à sortir son site des pénalités ?

A suivre ...

Bonsoir et merci pour le partage de cette étude. Très intéressante et très parlante malgré le faible échantillon. Je retiens (comme beaucoup ), le "taux de no-follow" comme le facteur le plus déterminant. Perso j'ai un site touché et du coup je viens d'aller voir sur ahrefs et je suis à seulement 7% de no-follow ! CQFD

Finalement, Google - et s'est logique - multiplie les signaux d'alerte en se basant sur de plus en plus sur de moyennnes et d'écart-types. Et quand on s'en éloigne trop (de la moyenne) on sort....

Ca me fait penser que les sites de CP était sans doute trop systématique dans la longueur des articles, périodicité de leur publication, absence de contenu "média", proportion de no-follow etc...!

Pour le coup tu me prends un peu a contre pied avec cette analyse. Je ne m'etais meme pas posé la question de la part de domaines pointant ou tout du moins pas de cette facon.

Chapeau bas belle analyse

Bonjour,

Merci pour cet article qui me semble pertinent. C'est une analyse qui n'est sans doute pas exhaustive mais qui a le mérite de s'appuyer sur des éléments tangibles, ce qui lui procure d'autant plus de crédibilité.

Je sais ce que représente comme travail la rédaction de billets documentés... Respect

Bonjour Daniel,

Bravo pour cette étude / analyse. Tes propos confirment les tendances que l'on pouvait lire à droite à gauche depuis quelques semaines.

Avoir des chiffres sur des exemples concrets est encore plus "rassurant" sur ce qu'il faut faire ou ne pas faire. Pour ma part je te rejoins dans ton analyse. Par chance je n'ai eu qu'un seul site qui a vraiment connu une penalité et très clairement celui-ci était trop optimisé (aussi bien son contenu que son netlinkking).

Bonjour,

ton analyse est vraiment pertinente lorsque l'on parle de "thématiques générales" et j'ai effectivement constaté les mêmes corrélations, mais pas une seule personne (pour l'instant) n'explique les résultats affolant que l'on trouve sur la thématique C..sino en ligne... En effet, tes résultats ne collent pas du tous avec ceux qui pratique le H..cking de NDD je ne les citerais pas, ça ne sert a rien il sont plus que facilement repérables.. et ceux qui ne le pratiquent pas mais qui tapent la première page avec un profil de BL heuu comment dire ... absolument pas "naturel" !!

Ex : C..sinojeux/com ...

Un rapide coup d'oeil sur Open site explorer et l'overview d'ahrefs pour comprendre !! (ou pas lol).

0% de nofollow..... (mais il est vrai, une grande variété de bl...)

Merci encore pour tes tests et résultats sur Pinguin. Et je suis tout a fait d'accord avec toi sur le fait qu'on est tous plus ou moins BH ;) même ceux qui croient être tout blanc.

Jere

Merci pour cette analyse complète et très détaillée ! De l'excellent boulot. Je rejoins ce qui se dit au dessus : on entend dire beaucoup de choses sur le phénomène pinguin mais on en sait finalement assez peu. Une vraie étude avec de vrais tests est plus qu'utile pour savoir réellement comment réagir devant cette algorytme.

Tres bon article, avec une approche <> cela change des gens qui affirment juste en se reposant sur le ego.

J'ai eu un jeune site touché par Penguin car il était suroptimisé sur une expression (un bug sur un commentaire de blog). Le site est resté 10 jours dans la sandbox de Google puis est revenu après quelques ajustements.

Si Penguin s'en prend à votre site et qu'il n'y a pas de gros abus, rien n'est perdu.

Génial ce test et merci de l'expliquer aussi clairement. L'erreur que tu as peut-être fait est de croire que tout est lié. Il n'y a peut-être qu'1 seul facteur entraînant la pénalité. Par exemple sur l'histoire des Subnets au lieu de chercher une analyse vaseuse, c'est peut-être juste que ce facteur n'est pas pris en compte.

En tout cas, je suis persuadé, comme toi, que Google essaye de lutter contre :

- les ancres trop optimisées

- les sites ayant trop de liens dofollow

- les sites ayant recours à des échanges de liens simplistes.

Salut DJ !

Bravo pour ce mix et merci pour le travail que tu a réalisé pour nous.

Juste un truc si ça peut intéresser certains...

On est d'accord que ces "critères" ou "filtres" executés par penguin, on en parle depuis 3 plombes ? N'est ce pas ?

Tels qu'ils sont décris, ici et ailleurs, certains semblent tellement "simplistes" (le pourcentage de nofollow par exemple, n'a rien d'algorithmique) qu'il est impensable que ces facteurs n'aient pas été déployés avant.

Mon idée c'est donc : Trop simple pour que ce soit ça.

Si on se place du côté des moteurs, la grosse problématique, n'est pas tant de trouver des indicateurs de qualité mais surtout de trouver des bons indicateurs qui puissent aussi être utilisés de façon optimale (toujours dans cette stratégie d'économie des ressources).

Tout ça pour dire que, des indicateurs de qualités ou de SPAM, tels que la sous représentation du nofollow par exemple, en soit c'est surement une bonne idée mais la plus grosse difficulté pour un moteur à mon avis, c'est de décider quand appliquer ce filtre. Et cela m'étonnerait qu'il le soit systématiquement.

Si un pro des algorithmes en IR et des big data (Sylvain Peyronnet par exemple) passe par ici et veut bien nous donner son point de vue là dessus ce serait Sympa. :)

Pour finir sur le nofollow, malgré tout ce que l'on dit, et qui me parait être du bon sens (ne pas abuser du dofollow), ça me saoule de créer des liens en nofollow, alors je ne le fait pas.

Résultat je n'ai jamais plus de 5% de nofollow sur un site, et jusqu'à présent je n'ai jamais été pénalisé. Bien sur je varie les ancres et je fais pleins d'autres trucs pour que cela soit le plus naturel possible.

C'est une des raisons qui me fait dire, ok pour le nofollow comme indicateur, mais cela m'étonnerait fort qu'il soit systématique.

NO ONE CAN RUN A TEST ON 40 SITES AND TELL YOU "THAT IS HOW THINGS ARE" !

There is NO change what so ever on REAL SITES with REAL CONTENT with AGED CONTENT.

Ton analyse est vraiment intéressante, merci pour le temps que cela à du te prendre et l'explication simple ;)

Sorry I do not write well French.

I assume you will not publish this anyhow.

How you can claim to understand Google with tests on 40 sites is beyond me!

Sorry for being honest.

Voilà une bonne enquête qui offre des résultats concrets et pertinents. Merci à toi Daniel !

For english readers : I've updated the end of this post. Check it out ;)

@Raph : non, aucun changement dans mes recommandations. Il faut une base saine, un contenu pertinent et des liens variés

@Mikiweb : je crois malheureusement que tu n'es pas le seul à ne pas comprendre leur vision du SEO... :(

@Ramzi : non, car l'essentiel est de varier les liens. Parfois on va chercher de nouveaux noms de domaine, parfois on va renforcer les liens depuis un même domaine.

@Phil : malheureusement, je n'ai pas trouvé de telles corrélations

@Human easy Spinner : non, car le nombre de visite ne dépend pas des liens mais des requêtes et du marché sur lequel tu te positionnes.

@Emmanuelle : moi non plus à vrai dire, mais c'est Excel qui gère le calcul comme un grand...

@Un affilié : trop dur à détecter pour la pub. Surtout que Google peine déjà à remarquer les achats de liens...

Bonjour Daniel,

Encore un excellent billet !

En ce moment, je réalise un test pour savoir si des liens SORTANTS pointant vers des sites à forte notoriété peuvent apporter une crédibilité au domaine du site sur lequel ils sont situés.

amicalement

Je ne suis pas sûr d'avoir tout compris sur les nofollow. Ton étude, Daniel, semble montrer que les sites pratiquant le "nofollow" sont moins impactés. Ai-je bien compris ?

Ton décorticage du filtre Penguin est assez intéressant. C'est un article qui encore dû te prendre pas mal de temps :)

Je retiens particulièrement un point : le fait qu'il est plus naturel d'avoir plusieurs liens qui pointent vers un même site, que ceux ci soient en do ou no follow.

C'est à mon avis un critère central à respecter pour éviter les futures pénalités GG.

On m'avait envoyé le lien vers un autre de tes articles, "Black Hat, liens et redirections". Comme il était très intéressant j'ai poursuivi sur celui-ci. Est-ce que tu peux nous en dire plus sur ton indice de corrélation ? Les chiffres qui en ressortent paraissent vraiment extrêmes.

Je ne suis pas du tout dans le domaine du referencement mais je peux confirmer avec mon site votre analyse. J'ai trois blogs qui ont fait 80% de lien entrant vers ma boutique. Je suis pénalisee depuis le mois d'avril. Je retravaille tout ça en espérant une amélioration.

Bien vu! Il faudra de plus en plus faire gaffe à la sur-optimisation des ancres et à la diversité des liens! Mais nous verrons bien ce que nous réserve Google comme prochaine surprise!

Un petit mot sur la notion de coefficient de corrélation :

- proche de 1 : corrélation positive (qd A augmente, B aussi)

- proche de -1 : corrélation négative (qd A augmente, B diminue)

- proche de 0 : pas de corrélation (qd A monte, B peut monter ou descendre, idem qd A descend)

L'interprétation d'un coefficient valant 0,5 est complexe car deux variables sont corrélées ou non, la notion d'être à moitié corrélé n'a pas un sens vraiment explicite... Personnellement, par rapport aux valeurs que tu donnes, je pense que le -39% et le -30% montrent des points que l'on ne sait pas interpréter.

Sinon, est ce que tu sais si tu as fait de la corrélation linéaire ou multiple ? Pour ensuite valider tes hypothèse, il faudrait que tu fasses un test de student empirique pour vérifier que le coefficient estimé que tu donnes est proche du vrai. Certaines valeurs sont tellement proche de 1 que cela parait bons, pour d'autre c'est moins sur.

C'est quand même du bon boulot en tout cas, bravo !

Bonne analyse effectivement, j'ai noté sensiblement les mêmes observations (loin d'être aussi approfondies) sur certains des sites que je gère ayant été impactés.

Je précise que je débute en référencement (notamment grâce à ce blog qui se montre très utile :)

Je ne suis pas sûr non plus que l'incitation de Google à utiliser un référencement 100% White Hat, malgré le côté louable de la chose, soit bien réaliste (même si celà permettrait plus ou moins de placer chaque site sur un "pied d'égalité", corrigez moi si je me trompe)

Bonjour,

Je ne suis pas une pro du référencement mais j'ai pu apprécier la qualité de votre article.

Une phrase m'a quand même interpellée :

"Il est "louable" de la part de Google de vouloir faire le ménage, mais je crois réellement qu'ils vivent dans un autre monde, rempli d'arc-en-ciel, de petits coeurs et de bisounours :"

+1

Mais j'ajouterais quand même "Quand le sage montre la Lune, l'idiot regarde le doigt !"

"Louable" ?...je crois que Google nous prend pour des imbéciles ! Dans ce monde hyper concurrentiel et individualiste où tout n'est que pognon et où chaque bisounnours joue des coudes pour bousiller le voisin, Google n'échappe pas à la règle et n'est pas arrivé à ce niveau là en cueillant des fraises.

Qu'ils s'habillent en clown et distribuent des su-sucres en prônant le naturel, mais qu'ils s'appliquent à eux-même ces mêmes règles !

Pour ma part, mon site est pingouinisé et je n'arrive toujours pas à comprendre ce qui ne va pas, ce qui fait que tout d'un coup mon site ne vaut plus rien, mon travail ne vaut plus rien, que le travail des rédacteurs ne vaut plus rien et que les internautes soient priés de circuler !

Je ne suis pas une tricheuse ou une malhonnête mais la présomption d'innocence ne veut plus dire grand chose depuis la fin avril !

Bon courage ...euh...bonne chance surtout car on y passera tous !

Excellente analyse de Google Penguin, ces tests sont vraiment parlants et offre une bonne vision du linking à adopter pour éviter des risques de pénalité.

Après en ce qui concerne le contenu d'un site, il s'agit juste de produire un contenu de qualité qui intéresse les lecteurs, faire un site agréable à lire et ne pas forcément le penser au terme de SEO.

Salut Daniel, ton analyse est très intéressante et je pense que plusieurs facteurs soulevés dans cet article sont importants à prendre en compte pour les nouveaux liens à se créer.

Par ailleurs, tu fais bien de préciser qu'il faut prendre les résultats avec des pincettes et notamment pour les liens Nofollow. J'ai testé une vingtaine de sites non pénalisés durant ces dernières semaines et j'ai remarqué qu'ils avaient moins de 5% de liens nofollow, ce qui est le contraire de cette analyse.

Merci pour cette approche intéressante, depuis le pingouin les choses se sont durci pour les spammers.

Mais tout n'est pas rose et votre analyse servira au moins à ceux qui comme moi ont vu certains de leurs sites pénalisés sans pratiques douteuses de rendre leur linking plus naturel aux yeux du moteur.

Merci encore pour votre travail de fourmi.

Balèze cet article je l'avais pas vu passer ! J'aurais bien ajouté l'age du domaine et un indice sur la diversité des ancres....

Merci :)

Article très bien rédigé, compréhensible par tous. Cela à été un réel plaisir de le lire. Sur certains forums connus pour le référencement, on aimerait bien voir de telles analyses... avec cette qualité de rédaction :)

Toutefois, malgré cette analyse fortement poussée sur les BL, je ne peux pas concevoir que le manchot ne se base que sur ces critères. C'est ce que tu affirmes aussi Daniel.

En effet, comme le stipule un des webmasters ici, le problème de l'abus de publicités, de l'affiliation et des critères onsite engendrent pour ma part, un fort % des pénalités du satané manchot.

Après avoir étudié une multitude de sites pénalisés ou pas, j'en arrive à cette conclusion: google ne sait plus quoi faire pour endiguer le spam.

Pour des requêtes très concurrentielles, les sites qui arrivent en première page sont pratiquement tous du spam, donc rien de naturel. Ce nouvel algo, pour ma part, a engendré des dommages collatéraux considérables sur des sites whitehat d'excellentes qualité.

Quand tu vois les résultats du mot clé "construire piscine, il y a de quoi se poser des questions sur toutes les analyses des pros. "j_ayen.free.fr" arrive en tête des résultats et souvent 2 ou 3ième.

Donc, les analyses... Google se perd lui-même dans ses méandres complexes. Ce dernier algo est de la foutaise car ils ne savent plus quoi faire ! Le coeur de Google était les votes, donc les BL, mais il faut croire que désormais... il arrive à bout. A eux de trouver une autre méthode pour classer les sites.

Bien à toi et continue tes articles savoureux de contenus enrobés de styles.

un simple échange de lien, un commentaire de blog ou encore un lien dans un annuaire est par définition un lien non naturel, ce qui vous fait donc basculer du côté obscur.

Ce n est pas un deux liens par jour quisont sanctionnés, mais plutot quand il y en as plus de dix.... caar la ce n est plus un humain qui est derriere son site.

une stat qui manques, combien de ces sites sont sous wordpress?

Vu qu il y as plein de plugins pour faire ce genre de choses, et pour gérer les liens, c est normal que ceux ci soient impactés.

Réferencer et administrer un site demande du temps, et que l'on soit un humain qui s adresses aux humains, et pas à Google, le secret d un bon SEO se situes ici.

Bien bien bien... j'estime que 50% du boulot SEO c'est de l'auto formation / partage en continue. J'ai donc lu énormément d'articles sur Pingouin et à la suite d'un lien via WRI d'un contributeur, je plussoie son avis comme faisant de celui-ci le meilleur.

Mon seul site Pingouiné valide ton analyse (no follow en particulier) mais ce n'est pas seulement ça qui me fait liker.

Il semblait sortir de l'empirisme des diverses analyses, que le filtre se déclenche par pallier UP à ne pas franchir (genre au dessous de telle proportion on n'est pas sanctionné). Ton article insère une nouvelle notion qui me plaît car affreusement logique : il existe aussi peut être un pallier DOWN.

Diversifier les domaines référents... mais appuyer quand même la contribution, non pas avec quelques commentaires sporadiques mais avec un vrai suivi.

Si on reprend une version Google des 10 derniers commandements officiels : "Participez aux activités en ligne relatives à votre communauté".

Oui telle est la parole de Dieu... et en la matière, une vrai participation communautaire est constituée par :

- Des commentaires parfois long et construits

- Des commentaires parfois plus courts.

Mais jamais par un commentaire isolé... En la matière, il s'agit souvent juste d'augmenter artificiellement le nombre de référents.

Oula attention ! De temps en temps, un commentaire isolé peut (doit) faire aussi partie du naturel... mais ne doit pas constituer la base dure.

En résumé, ta phrase que je partage le plus est "Le référencement naturel n'est pas compliqué, il est complexe". Il est complexe, justement car désormais le naturel est multiple.

Après une petite nuit de réflexion... Si comme nos amis contributeurs "english speaking" le suggèrent, les sites anciens & avec du contenu n'ont pas bougé (constatation que je partage)ne peut-on pas pensé qu'il y aurait deux poids deux mesures?

A savoir peut être que pour les sites anciens, dont l'essentiel du linking aura peut être "naturellement" fait à une époque où par exemple le "nofollow" était moins courant, le filtre accepterait des proportions de dofollow qui serait pénalisé sur des sites plus récents.

Ceci pourrait expliquer pourquoi sur certaines requêtes on trouve des top positions avec un design horrible (j'ai rarement vu pire en effet que le "construction piscine" de jpayen en effet) et autres pages free.

Très bon article, très complet et intéressant. Néanmoins, je me pose pas mal de question concernant la qualité des liens entrant. Nous avons un site "propre", pas de mots clés dans tous les sens sur la page, des liens en no follow, quelques annuaires. Quand je regarde nos concurrents qui sont dans les 3 premiers résultats Google, je m'aperçois que ces sites ont des backlinks de sites d'échanges de liens, souvent payant ou bardés de pub ! Où est la qualité ?

Nous sommes peut-être un peu pressé de monter, c'est vrai, mais quand même, notre site n'est pas tout jeune et ça monte tout doucement...

Nous continuons dans la qualité et des liens les plus naturels possible mais c'est long ;)

Je voudrais attirer votre attention sur la problématique des sites immobilier.

Je gère plusieurs sites de ce type et un de celui-ci a été touché par pingouin.

Hors quand vous évoquez la part des 3 premiers sites qui vous fait des backlinks, dans le domaine immobilier il s'agit toujours de portails (comme seloger) qui vous inondent de milliers de backlinks renvoyant par exemple vers une page d'un bien. Ces backlinks sont automatiques et souvent utilisent en gros la même ancre.

Nous ne pouvons agir sur ce phénomène.

Si encore chaque portail envoyait a peu près le même nombre de backlinks vers nous, nous aurions une répartition équitable mais malheureusement ce n'est pas le cas.

le site touché par ex. se voit backlinké par 500 000 liens d'un même portail sur un total de backlink d'environ 700 000.

Le 2eme portail nous backlink avec 30 000 liens, ainsi que le 3eme.

Pour finir, 2 questions :

Savez-vous si google tient compte du domaine d'activité du site ?

Pensez-vous que le portail avec ces 500 000 backlinks est la cause (principale) de notre baisse ?

Merci pour cet article constructif !

Bonjour, notre site a été blacklisté, sans qu'une explication précise ne me soit donnée par notre webmaster, ni référenceur. La piste inavouée la plus probable semble être un sur-referencement: liens et mot-clef unique sur-utilisé. La redirection 301 vers un nouvel URL, qui a semble-t-il récupérer ces liens, sera-t-elle suffisamment fiable ? Tous les conseils sont bien venus. Merci.

@Pascal - ton site rentre parfaitement dans le profil de lien décrit dans l'article ci-dessus. Les 3 premiers domaines référents (supertravelnet.com, lien-annuaires.com, netvouz.com) représentent 53.8% du linking. Es-tu sûr que ton Webmaster ne t'en aie pas parlé. WebGazelle

Plusieurs métros après la bataille mais je le trouve très intéressant ce protocole. Je serais curieux de mener la même étude aujourd'hui et j'ai bien l'impression que certains critères provoqueraient la surprise.

Laisser un commentaire