Pour avoir du trafic, il faut être bien positionné dans Google. Mais encore faut-il que les différentes pages du site soient bien présentes dans l'index de Google.

Pour cela, il existe un certains nombre de bonnes pratiques basiques à mettre en place sur son site Internet. Attention, elles ne se valent pas toutes et ne sont pas systématiquement obligatoires.

Ces techniques de base vous assurent cependant un bon maillage interne et une indexation correcte de vos différents contenus dans Google et dans les autres moteurs de recherche.

Indexation et structure du site

N°1- La structure des contenus

C'est la base de la base. Une bonne structure de contenus va permettre à vos visiteurs de naviguer de manière logique et fluide dans tout votre site Internet. Ce qui est vrai pour eux l'est aussi pour les moteurs de recherche. Si la structure est bien conçue, et si vous mettez en avant certains contenus comme les articles récents, vos meilleurs publications ou vos posts mis à jour, vous allez faciliter le travail d'indexation de Google.

En d'autres termes, vous devez être capable de diviser vos contenus en groupes homogènes que vous allez pouvoir mettre en avant (en règle générale il s'agira de vos catégories). Vous aurez dans chacun d'elle des articles dont certains seront mis en avant en fonction des besoins des internautes ou de vos objectifs. Vous pourriez ainsi donnez plus d'exposition à :

- certaines produits ou services

- le plan d'accès

- un tutoriel

- un article qui fait le buzz

- ...

Sur ce sujet précis, je vous conseille un article que j'avais rédigé il y a quelques temps, et qui est toujours d'actualité sur la structure de vos contenus.

N°2- Le maillage interne

Là aussi, c'est une des bases du référencement naturel.

Pour être indexés, il faut que vos contenus soient accessibles. Si votre nouvel article n'apparaît pas sur la page d'accueil, il sera indexé moins rapidement. Il en est de même pour un ancien article que vous venez de mettre à jour et qui peut se retrouver perdu au fin fond de votre site Internet.

Google peut parfois mettre un temps important avant de prendre en compte vos modifications ou vos nouvelles publications. Pour éviter ce désagrément, il faut améliorer votre maillage interne.

Théoriquement, à ce stade là, vos contenus sont bien structurés. Vos catégories sont logiques et contiennent des publications ayant des thématiques proches, tout en mettant en avant constamment sur votre site vos pages clés.

Mais cela ne suffira pas, surtout sur un site qui publie régulièrement ou qui possède déjà beaucoup d'articles. Pour cela, je vous conseille (très) fortement de mettre en place les techniques ci-dessous. Là encore, rien de novateur : c'est la base d'un bon maillage interne, quel que soit le secteur d'activité que l'on cible :

- un système d'articles relatifs ou de produits associés.

- avoir un chemin de navigation (vous trouverez ici un code optimisé pour WordPress).

- créer un module d'articles à la une, des posts les plus commentés ou encore des publications qui viennent d'être mises à jour.

- créer une page "Plan de site" qui récence tous vos contenus.

- ...

Le but une fois de plus, c'est de faciliter l'accès à tous vos contenus, les plus récents et les plus anciens. et ces systèmes doivent également vous permettre de mettre des contenus ayant une thématique proche, ce qui sera utile à la fois pour le moteur de recherche et vos visiteurs. Là, on va surtout chercher à optimiser l'indexation dans Google.

Et si en plus vous voulez améliorer votre positionnement, vous ne devez jamais oublié que le contenu même de vos nouvelles publications doit inclure quand c'est pertinent des liens vers vos anciennes publications. Cela apporte une plus-value au lecteur (comme précédemment dans cet article avec un lien vers un hack WordPress et un autre vers un article sur la structure d'un site), tout en permettant de redonner vie à des articles un peu trop enfouis dans votre site.

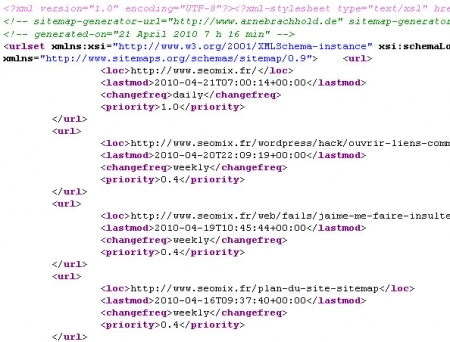

N°3- Le fichier sitemap

Le fichier sitemap est un fichier xml qui récence toutes les URL de votre site. Pour être efficace, vous devez le soumettre à Google dans le centre Webmaster. Ainsi, le moteur de recherche va pouvoir connaître d'un seul coup toutes les URL de votre site Internet, et il devrait donc être capable de toutes les indexer.

Attention, cela ne remplacera JAMAIS un bon maillage interne ou une bonne structure, mais cela va faciliter l'indexation. Sur un site ayant un faible nombre de contenus, ce fichier ne servira à rien. Mais sur des gros sites avec des milliers de pages, cela peut vraiment aider, surtout quand vous prenez en charge l'optimisation en cours de route et que rien n'avait été fait avant...

Les mauvais contenus

A l'inverse des bonnes pratiques, il faut aussi combattre les mauvaises. Là encore, il s'agit des bases du référencement.

N°4-Duplication de contenu interne

C'est une véritable plaie pour le référencement : je parle des contenus identiques que l'on retrouve sur plusieurs pages d'un même site. En soi, Google ne pénalise pas un site pour cela.

Mais plus un contenu sera dupliqué :

- moins Google va indexer votre site (car il trouvera vos contenus redondants et moins pertinents)

- plus votre maillage interne est mauvais, car vous ne mettez pas suffisamment en avant les publications importantes.

C'est une plaie sur WordPress (j'en parlais ici), mais c'est malheureusement le cas sur de nombreux autres CMS.

Dites-vous bien que dès que vous trouvez un contenu dupliqué, cela n'a pas d'intérêt pour le visiteur. Cela n'en a donc aucun pour le moteur de recherche...

N°5- Les mauvais formats

Deuxième grand freins dans les mauvaises pratiques à bannir : les contenus mal générés ou illisibles. Google est un moteur de recherche parfois capricieux : il n'arrive pas toujours à lire correctement certains formats.

Pour faciliter l'indexation Google de votre site, il faut donc bannir le flash (qui est illisible pour Google). Il est aussi conseillé d'éviter

- les PDF (qui sont indexés mais qui ne remplaceront jamais une vraie page avec du contenu texte)

- le javascript (qui lui aussi commence a être interprété mais pas toujours de manière optimale)

Dans les bonnes pratiques d'indexation, pensez aussi à la balise Alternative pour vos images, de manière à pouvoir expliquer concrètement de qui "parle" l'image.

N°6- Les liens externes

Dernière bonne pratique de l'indexation : la création de backlinks. On peut dire ce que l'on veut, mais le contenu seul d'un site ne suffira jamais à être indexé, et encore moins à être bien positionné.

Certes, vos articles doivent être pertinents et uniques. Oui, votre site doit être correctement conçu et paramétré. Il est aussi évident que votre structure et votre maillage interne doivent être efficaces et bien pensés. Mais cela ne vous dispensera JAMAIS de créer des liens vers votre site. Les liens vous apporteront plusieurs choses :

- de la popularité

- de la "crédibilité"

- une meilleure indexation

- du trafic, et donc des clients...

Et si vous alternez correctement les liens vers votre page d'accueil et des pages profondes, vous aurez tout compris pour pouvoir correctement indexer tous vos contenus.

En conclusion

Vous l'aurez compris : tout ce qui est dit ici fait parties des bases d'une bonne indexation pour Google et les autres moteurs de recherche. Il s'agit purement et simplement de bon sens, et pourtant de nombreux sites sont très loin de respecter ces standards.

D'ailleurs, en parlant de fondamentaux du web et/ou du SEO, je vous conseille aussi la lecture de l'article "Sites web : ne négligez pas les fondamentaux" paru cette semaine par RenardDuDesert chez Axenet.

Sources images :

- Working Girl (image supprimée depuis de Flickr)

32 Commentaires

Tu reprends les bases du réf certes, mais une piqûre de rappel est toujours la bienvenue ! Comme tu le dis très bien, beaucoup de sites sont encore loin de ces standards (je pense notamment à l'utilisation du Javascript), ce sont des bons conseils pour tout le monde ;)

Bonjour Daniel,

Pour les pdf, ils sont quand même bien indexés et le contenu est bien vu comme du contenu texte par Google ?

Pour moi les pdf sont similaires à du contenu texte (contrairement à une image) et sont plutôt bien référencés dans certains cas.

Cool article Daniel, toujours bon de se remémoré les bases que l'on oublie vite!

Concernant les backlinks et le fait que le contenu seul ne suffit pas au référencement, oui et non!

Car chercher à obtenir (volontairement) des backlinks n'est pas forcément la clé de la réussite. Si le contenu sur le site est très bon, les backlinks se créeront automatiquement et seront encore plus crédible que des backlinks 'fabriqués'.

Bonjour Daniel !

Le point N°6 me rappelle un article US retweeté cette semaine, qui démontrait que la pertinence (relevance) était désormais le (re)nouveau (du) Page Rank.

A bientôt

Hum… si je me trompe pas, WordPress gère les URL canoniques (en tout cas sur mon WordPress s'y est et je ne les ai pas configurées). Donc dire que WordPress c'est de la merde en contenu dupliqué => FAUX !

une petite remarque sur le javascript : ce n'est pas forcément un handicap pour le seo, ça dépend des cas.

Ensuite, le problème peut-être contourné, en donnant autre chose à googlebot qu'aux visiteurs (c'est se compliquer la vie mais certains le font...)

Petit article sympathique dans la veine de ce que tu fais normalement, du conseil applicable directement si des personnes ne connaissaient pas encore ses fondements.

En revanche, ça m'a aussi permis de revoir ton article très bon sur la lutte du DC avec WordPress qui date de 2010 mais toujours d'actualité et d'embrayer sur un article sur les 302 super intéressant :)

Superbe article Daniel, merci.

Maintenant je vais modifier énormément mon site, car y a du boulot.

Aussi, je me demandais à quels moment, pour quels fautes, Google pouvais supprimer notre site de son moteur de recherche ?

Merci :)

Joli récapitulatif sur l'indexation d'un site web.

Pour moi, un bon maillage interne et de nombreux backlinks (notamment des liens vers les pages internes) suffisent à bien indexer un site, surtout pour les petits sites web.

Personnellement, je n'ai jamais utilisé de page "Plan de site" et de sitemap.xml et je n'ai jamais eu de problème d'indexation de contenu.

Sinon, étant un gros utilisateur de WordPress, je trouve l'image du chat très réaliste :-).

Merci pour cet article qui reprend les classiques mais qui sont toujours pertinents. Pour ma part, je serais tenté de relativiser sur les PDF. À mon sens, si les PDF présentent un contenu additionnel et différent du contenu de la page, cela peut être pertinent. Tout est une question de qualité après. Le truc à éviter, c est souvent les mêmes Pdf que l on retrouve sur plusieurs sites qui peuvent être considérés comme de la duplication de contenu.

Un bon article de fond comme d'habitude. Je vais envoyer le point 5 à une cliente qui a un site full flash à la Gandi sitemaker full flash, horrible !

Je ne vois pas trop pourquoi tu déconseilles les PDF. Je ne pense pas qu'ils pénalisent le SEO, au contraire même.

Si on prend l'exemple des produits high-tech, je m'imagine mal balancer un manuel d'utilisation de 200 pages en dur en HTML car justement ça risquerait de saboter toute mon optimisation de maillage interne en diminuant le poids de mes contenus rédactionnels optimisés !

Les contenus PDF étant par ailleurs indexés ils restent "cherchables" et sont je pense pris en compte dans le maillage avec un poids moindre.

Après si tu évoques la possibilité de construire un site à bas de PDF je n'ai jamais vu ça de ma vie, mais qui sait ...

Décidément, elle te plait cette image du chat ^^ !

Sinon, des bons petits rappels...

@Emmanuelle : j'aime bien ce chat ^^

@Fabien, @Aurele, @Arnaud : je ne dis pas que le PDF s'indexe mal, mais c'est surtout qu'il ne contribue plus du tout de la même façon au maillage interne du site, et donc à son indexation sur Google. Je sais très bien que le téléchargement de PDF est très bon pour certains secteurs d'activités.

@Zetura : la balise canonical est une rustine contre le contenu dupliqué : oui Google arrive à la lire et l'interprété, mais éviter le contenu dupliqué en amont dans le contenu et le maillage interne sera toujours plus efficace, ce que ne fait pas du tout WordPress par défaut.

@Fab : d'accord avec toi, mais si un site n'a aucun lien à la base, impossible pour un visiteur de le trouver, et donc de créer des liens naturels. Le contenu seul ne suffit pas.

Allez pour le fun je te donne l'exemple d'un de mes sites qui je pense remet en question les paradigmes du contenu et du linking.

Je précise que le site a 1 lien entrant depuis mon blog (http://pix-geeks.com) c'est tout : http://rachat2credit.fr/

... PR3

Et j'en ai des douzaines comme ça, ce n'est pas un cas isolé

Le PR est un autre débat : là je ne parle que de l'indexation. Sans ce lien, ce résultat n'aurait pas été naturellement dans l'index de Google.

Pour le contenu dupliqué j'ai mis en place une usine à gaz relativement efficace mais qui consomme du temps.

Si ça vous intéresse il faut bien sûr utiliser les extrait que propose wordpress et qui sera repris pour la home par exemple.

Ensuite on va créer 3 champs personnalisés :

- 1 pour ajouter un titre indépendant en home (qui sera donc couplé à l'extrait),

- 1 pour un second titre qui sera utilisé pour le tag que je met à l'article (j'en mets qu'un),

- 1 pour l'extrait qui sera utilisé pour la page de tag.

Comme ça on a des pages de tag sans duplication, une page d'accueil sans duplication. A côté j'indexe pas les archives et les catégories.

Bon après on peu fonctionner autrement c'est à dire avoir des pages de catégories indéxées et des pages de tags non indexées.

Mais l'intérêt des pages de tags c'est que tu peu en créer de nouvelles plus facilement que des catégories.

Voilà voilà. Dites moi ce que vous en pensez..

++

Xav

@Daniel c'est sur mais sur 2 pages en DC par exemple, celle avec le plus gros PR va passer devant, donc ca compte quand même pas mal !

(PR4 au fait la page pas PR3 ;))

@Fabien

Ton site est actuellement en PR4 et non PR3, mais tu n'as pas qu'un lien entrant?

Open Site Explorer affiche 1733 liens externe pour http://www.rachat2credit.fr/ ...

oops, tu bloques les ancres optimisées maintenant ?

@Jérome : oui, je n'autorise que les prénoms, et éventuellement les pseudos. Et bientôt le champs URL ne sera disponible que quelques jours après la publication des articles.

Bonjour Daniel, tu n’évoques pas la profondeur des pages dans ton article?

C'est quand même un critère important pour l'indexation des URLs

@Fab quand je dis 1 lien entrant j'entends 1 lien en footer depuis tous les pages de mon blog.

Quand j'ai vu que j'étais passe PR4 j'ai rajouté quelques liens ici et la mais vraiment très peu..

Cet article redonne au linking interne ses lauriers qu'il a tendance à perdre dans cette mode effrénée de la chasse aux BL.

Pour la vitesse d'indexation à proprement parler n'est-ce pas aussi une bonne pratique bien boostante que de poster un lien de sa nouvelle page sur Twitter ou une photo sur Pinterest?

Je ne vois pas en quoi les PDF devraient être déconseillés, exceptés lorsqu'ils sont de purs duplicates de la version web, auquel cas un noindex est clairement nécessaire.

Google s'intéresse aux PDF depuis longtemps (notamment avec de l'OCR) et les contenus des PDF peuvent être tout à fait inadaptés au web. Proposer des PDF à googlebot peut être un atout à mes yeux, en proposant des contenus différents et uniques dans ce format, dès que c'est pertinent. Par ailleurs, Google découvre probablement les liens dans les PDF sans aucun mal ; leur prise en compte est un autre sujet :-)

Je vois que beaucoup bondissent au sujet cette reco sur les PDF, mais c'est bien logique, car tu livres la reco brute de décoffrage, en item de liste. Ça peut être très trompeur pour des débutants qui voient dans ton blog la bible du référencement :-)

@Baptiste : effectivement, je passe rapidement sur ce point dans mon article. Effectivement, Google n'a aucune difficulté à indexer les PDF, et cela depuis des années. Mais cela nuit quand même à l'indexation, dans le sens où le même contenu dans une vrai page HTML sera plus simple à indexer, et Google y suivra plus rapidement les liens pour naviguer dans la structure du site Internet.

Qu'en est-il de la profondeur des pages? N'est ce pas un critère à tenir en compte lorsqu'il s'agit d'indexer une URL?

Merci

Bonjour Daniel,

Une arborescence optimisée du site Web avec l'intégration d'un fil d'ariane facilite également une bonne indexation dans les différents moteurs de recherche.

amicalement

Bonjour,

Je pense également qu'obtenir des back links de sites faisant autorité (dans le sens où ils sont bien notés et référencés par Google) aide également à une indexation plus rapide, non?

@Romain: le plan de site n'est pas obligatoire, surtout pour un petit site, mais il accélérera franchement l'indexation de tes nouveaux contenus.

Amicalement,

Bruno

Toujours utile ce rappel des fondamentaux.

Merci!

Bonjour, une question référencement:

pour dynamiser le positionnement d'un site vitrine réalisé sous wordpress, avec majoritairement des pages statiques et une page de blog avec des articles, le fait de mettre des liens dans les articles vers les pages statiques du site est-il une bonne pratique? Est-ce que cela a un intérêt?

Merci par avance.

@Chevalier : oui, cela a un intérêt car cela donne plus de poids aux pages statiques. Attention, ces liens doivent cependant rester logiques pour l'internaute.

Laisser un commentaire