Le classement dans les résultats de recherche Google est essentiel pour garantir une bonne visibilité et attirer un trafic qualifié sur votre site. La première étape pour y parvenir est d'assurer l'indexation correcte de vos pages par le moteur de recherche. Dans cet article, nous vous proposons quelques conseils pour favoriser l'indexation de vos pages sur Google.

Comprendre l'indexation Google

Lorsque Google indexe une page, cela signifie que la page a été analysée et ajoutée à sa base de données, afin d'apparaître ultérieurement dans les résultats de recherche. Si une page n'est pas indexée, elle ne pourra pas être trouvée par les utilisateurs lorsqu'ils effectuent une recherche sur Google.

Dans les grandes lignes, voici le fonctionnement de Google pour indexer une URL :

- Exploration (crawl) : Google utilise des robots d'exploration, également appelés "Googlebots" ou "spiders", pour parcourir le web. Ces robots suivent les liens entre les pages pour découvrir de nouveaux contenus. Lorsqu'un robot découvre une nouvelle page ou une page mise à jour, il la transmet au processus d'indexation.

- Indexation : Une fois qu'une page est découverte par le robot d'exploration, Google l'analyse pour comprendre son contenu et son contexte. Cela inclut le texte, les images, les vidéos, les liens, etc. Google peut alors ajouter une page à son index s'il considère qu'elle est pertinente et de qualité.

- Exploration régulière : Google revient périodiquement sur les pages indexées pour rechercher de nouveaux contenus ou des changements potentiels. Si une page a été mise à jour ou modifiée, Google met à jour son index en conséquence.

L'indexation Google est essentielle pour que les pages web soient découvertes et classées dans les résultats de recherche. Les propriétaires de sites web peuvent optimiser ce processus en s'assurant que leurs pages sont accessibles aux robots d'exploration, en fournissant un contenu de qualité et en mettant en place des optimisations SEO pour améliorer la qualité globale de leur site et par conséquence leur visibilité dans les résultats de recherche Google.

Pour aller plus loin :

S'assurer que votre page peut techniquement être indexée

Il est essentiel de s'assurer que vos pages sont techniquement capables d'être indexées par les robots de Google. Voici quelques éléments clés à vérifier :

- La balise meta "robots" : assurez-vous qu'elle ne contient pas la valeur "noindex", qui empêche explicitement l'indexation de la page.

- Les directives présentes dans le fichier robots.txt : vérifiez que votre fichier robots.txt n'exclut pas les robots Google ou bloque l'accès des robots aux pages que vous souhaitez indexer.

- La qualité du code HTML de votre site : assurez-vous que votre page est correctement structurée et ne contient pas d'erreurs qui pourraient empêcher la bonne lecture des robots.

- Le temps de chargement de vos pages : un temps de chargement long peut freiner l'indexation de vos contenus sur Google. Nous vous conseillons donc d'avoir le temps de chargement le plus rapide possible (cela fera aussi plaisir à vos utilisateurs :) ).

Comment vérifier qu'une page ou une URL est indexée ?

Vous vous demandez pourquoi votre site n'apparait pas dans Google ? Il existe plusieurs méthodes pour vérifier si une URL est indexée. Les voici :

- Recherche directe sur Google : copiez simplement l'URL de la page dans la barre de recherche Google et appuyez sur Entrée. Si la page est indexée, elle devrait apparaître dans les résultats de recherche. Vous pouvez également utiliser la commande "site:" suivie de l'URL pour limiter la recherche à un domaine spécifique.

- Google Search Console : dans Google Search Console, vous pouvez accéder au rapport de l'index de la couverture pour voir quelles pages ont été indexées par Google.

- Outils tiers : il existe également des outils tiers comme Duplichecker qui vous permettent de vérifier l'indexation d'une URL.

En utilisant ces méthodes, vous pouvez facilement vérifier si une page ou une URL spécifique est indexée par Google. Cependant, gardez à l'esprit que l'indexation peut prendre un certain temps, donc si une page n'apparaît pas immédiatement dans les résultats de recherche, cela ne signifie pas nécessairement qu'elle n'est pas indexée. Il faut parfois être patient !

6 Techniques pour favoriser l'indexation de vos pages

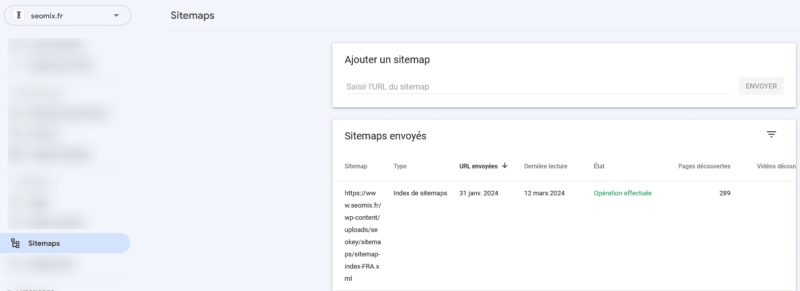

Ajoutez votre sitemap dans la Search Console

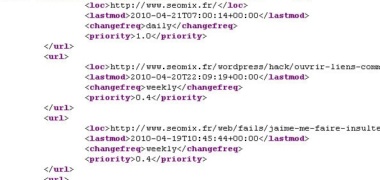

Le sitemap est fichier xml qui liste l'ensemble des contenus et URL d'un site. Il est très utile à Google pour récupérer l'ensemble des URL de votre site.

Voici la démarche pour ajouter votre sitemap à la Search Console :

- Connectez-vous à la Search Console : Accédez à la Search Console à l'aide de votre compte Google. Si vous n'avez pas encore ajouté votre site à la Search Console, vous devrez le faire en cliquant sur le bouton "Ajouter une propriété" et en suivant les instructions pour vérifier que vous êtes le propriétaire du site.

- Sélectionnez votre propriété : Une fois connecté, sélectionnez la propriété (c'est-à-dire le site web) pour lequel vous souhaitez ajouter un sitemap. Si vous avez plusieurs propriétés, assurez-vous de sélectionner celle concernée.

- Accédez à la section "Sitemaps" : Dans le menu de gauche, cliquez sur "Sitemaps". Cette section vous permet de soumettre et de gérer les sitemaps de votre site.

- Ajoutez votre sitemap : Sur la page "Sitemaps", vous verrez un champ où vous pouvez entrer l'URL de votre sitemap. Si vous n'avez pas encore créé de sitemap, vous pouvez le faire en utilisant différents outils en ligne ou des plugins si vous utilisez un CMS comme WordPress. Une fois que vous avez l'URL de votre sitemap, collez-la dans le champ et cliquez sur le bouton "Soumettre".

- Vérifiez le statut de soumission : Après avoir soumis votre sitemap, la Search Console commencera à le traiter. Vous pourrez voir le statut de la soumission dans la liste des sitemaps soumis. Assurez-vous qu'il affiche "Succès" pour indiquer que Google a bien reçu et traité votre sitemap.

Une fois votre sitemap ajouté avec succès, Google utilisera ces informations pour mieux comprendre la structure de votre site et indexer ses pages de manière plus efficace. Assurez-vous de vérifier régulièrement la Search Console pour surveiller les performances de votre site et résoudre tout problème éventuel.

Si vous utilisez l'extension SEO SEOKEY, sachez que la version PRO se charge automatiquement d'ajouter ce fichier sitemap XML dans la Search Console de Google !

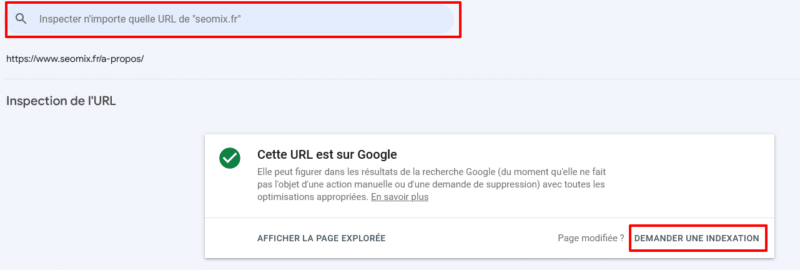

Soumettez vos pages à Google

Une fois que vous avez vérifié que vos pages sont techniquement indexables, il est important d'informer Google de leur existence. Voici deux méthodes pour soumettre vos URL :

- Utiliser l'outil de soumission d'URL individuelles dans la Google Search Console : une solution rapide, mais qui doit être utilisée avec parcimonie.

- Créer un fichier sitemap.xml pour votre site qui répertorie toutes les URL à indexer et le soumettre à Google par le biais de la Search Console : une approche plus efficace pour assurer l'indexation de plusieurs pages en même temps.

Optimisez la qualité de vos pages

Pour favoriser l'indexation de vos pages sur Google, il est également essentiel de proposer un contenu de qualité et de travailler sur l'optimisation SEO onPage :

Qualité du contenu

Google attache une grande importance à la satisfaction des utilisateurs dans ses critères d'indexation et de classement. Ainsi, veillez à proposer du contenu unique, pertinent et engageant qui répond aux besoins de ceux-ci. De plus, travaillez sur la présence de mots-clés pertinents et évitez les techniques de spam comme le bourrage de mots-clés ou la duplication de contenu.

Optimisation SEO onPage

Pour faciliter l'indexation par les moteurs de recherche, plusieurs éléments doivent être travaillés :

- Les balises meta title et description : elles doivent être soignées et inclure les mots-clés pertinents pour votre page.

- Les balises de titre (H1, H2, H3...) : il est important d'utiliser une structure hiérarchique claire dans vos titres et sous-titres.

- Le maillage interne : incluez des liens internes vers d'autres pages pertinentes de votre site pour faciliter la navigation des utilisateurs et des robots.

- La vitesse de chargement : un temps de chargement rapide contribue à améliorer l'expérience utilisateur et encourage Google à indexer vos pages.

- La compatibilité mobile : assurez-vous que votre site est adapté aux appareils mobiles, car Google privilégie l'indexation des sites mobile-first.

Mettez à jour vos contenus et travaillez le maillage interne

Mettre à jour le contenu d'une page pour y ajouter des informations et précisions supplémentaires dans le but de répondre du mieux possible à la requête d'un internaute, facilitera l'indexation de vos contenus.

Vous pourriez par exemple :

- Ajoutez un nouveau paragraphe, une image, une vidéo ;

- Ajoutez des liens internes vers la page que vous souhaitez indexer depuis des pages elles-mêmes indexées et générant du trafic ;

- Faites remonter votre URL sur votre page d'accueil pour que Google repasse plus rapidement sur votre URL et l'indexe.

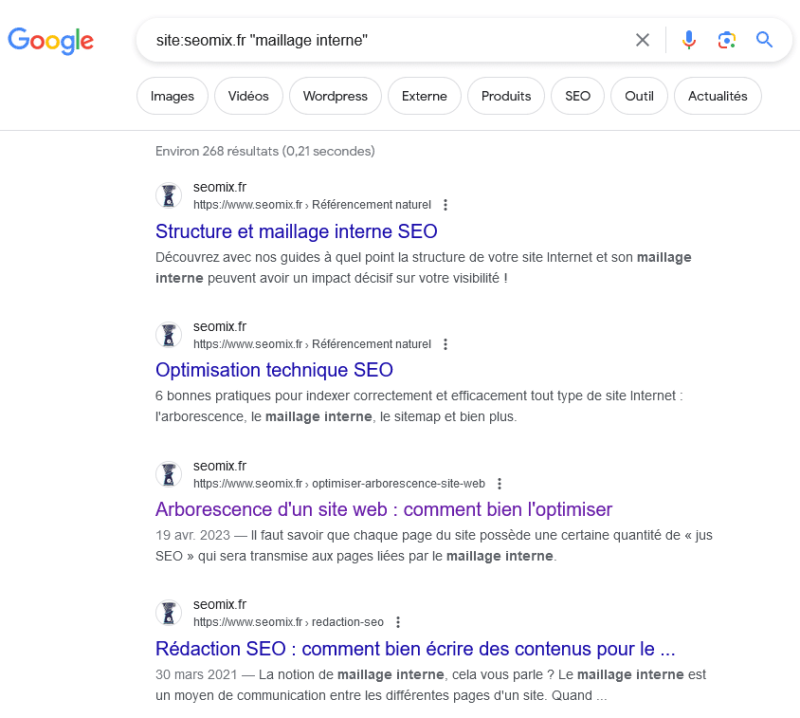

Pour trouver des pages pertinentes sur votre site sur lesquelles ajouter des liens internes, utilisez les commandes Google : dans l'exemple ci-dessous, Google nous liste les pages indexées évoquant le "maillage interne".

En cadeau, on vous offre ce bookmarklet qui vous permettra de lancer la commande Google ci-dessus :

javascript:q=window.getSelection().toString();if(!q)q=prompt("Search terms");if(q!=null){window. open("https://www.google.com/search?q=\""+q+"\"+site:"+location.hostname)};Pour le faire fonctionner :

- Allez sur l'URL vers laquelle vous souhaitez travailler le maillage interne ;

- Sélectionnez le mot clé sur votre page et lancez le bookmarklet. Vous trouverez ainsi des idées de pages sur lesquelles ajouter des liens internes vers la page à indexer.

Générez du trafic sur votre URL

Une URL recevant du trafic est un excellent signal aux yeux de Google pour valider la qualité d'une page. Alors n'hésitez pas à générer du trafic sur vos URL à indexer, vous verrez que cela peut grandement vous aider ! :)

Obtenez de nouveaux liens externes

Enfin, il est important de souligner que les robots de Google sont plus susceptibles d'indexer rapidement les pages qu'ils trouvent à partir d'autres sites déjà indexés. Ainsi, obtenir des liens externes, appelés backlinks, de qualité pointant vers vos pages peut fortement faciliter leur indexation.

Pour cela, travaillez sur différentes stratégies telles que le netlinking, la création de contenu à valeur ajoutée pour les autres sites, ou encore établir des partenariats et collaborations avec d'autres acteurs pertinents. De plus, n'hésitez pas à partager vos pages sur les réseaux sociaux afin d'augmenter leur visibilité et potentiellement générer des liens externes supplémentaires.

A ce sujet :

Et si vos pages ne s'indexent pas ?

Le problème vient probablement de vous et il va falloir vous poser quelques questions, notamment sur la qualité de vos contenus et, de manière plus globale, sur la crédibilité de votre site sur votre thématique ! En effet, les dernières mises à jour Google (coucou Help Full Content ^^) visent à chasser des résultats de recherche toutes les pages et site avec des contenus spammy, non crédibles ou ne répondant pas à l'intention de recherche sur les requêtes ciblées !

Si vous maitrisez votre sujet et proposer des contenus pertinents, vous ne devriez pas avoir de problème d'indexation ; et si c'était le cas, l'une des méthodes ci-dessus devrait vous permettre de résoudre vos problèmes !

Si vous avez des questions, remarques ou compléments, n'hésitez pas à laisser un commentaire et je me ferai un plaisir d'y répondre ! :)

Obtenez un devis personnalisé pour une prestation SEO !

Vous souhaitez que des experts SEO auditent votre site ou vous accompagnent dans le déploiement de votre stratégie ? Envoyez-nous un message et un expert de l'agence vous recontactera !

Laisser un commentaire